(一)前言

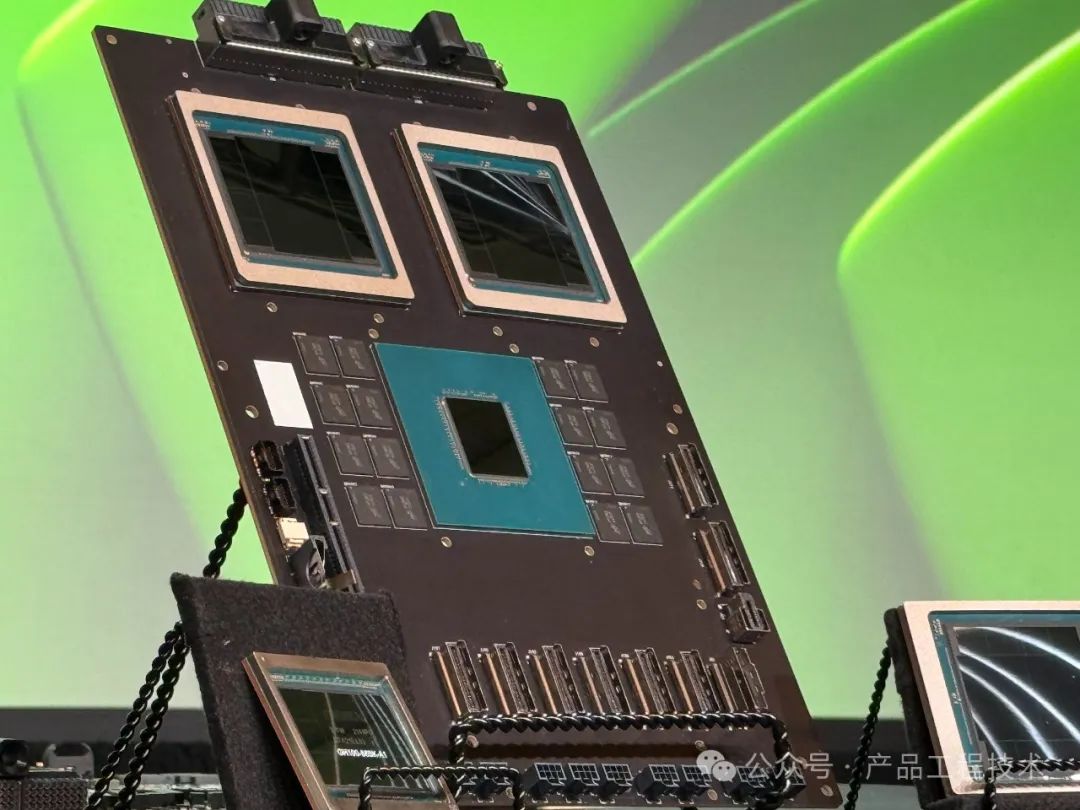

NVIDIA GB200是一款高度集成的超级计算模块,它是基于NVIDIA的Blackwell架构设计的。这款模块结合了两个NVIDIA B200 Tensor Core GPU和一个NVIDIA Grace CPU,旨在提供前所未有的AI性能。

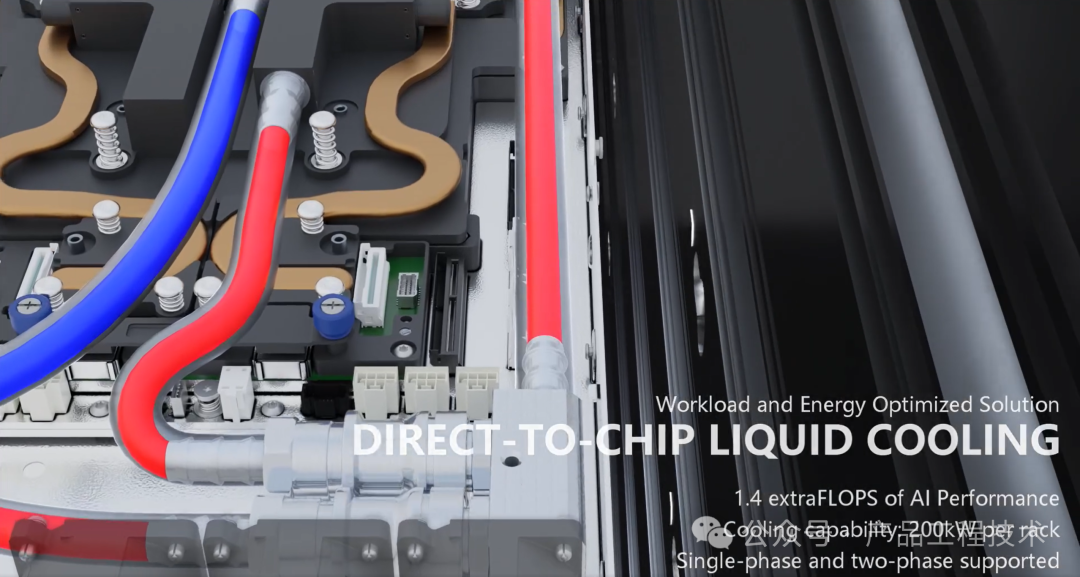

GB200 搭载液冷,产业链各参与方共促技术落地,我们认为,在 AIGC 驱动下,AI 算力芯片功耗不断增长,服务器亟需更高效的散热方式,全球 AI 芯片龙头英伟达(新品 GB200 搭载液冷)、AI 服务器厂商超微电脑(根据超微电脑2QFY24 业绩会纪要,预计 Q2 内扩产液冷机架)均为液冷技术作出背书,叠加国内产业链协同推进(如三大运营商于 23 年 6 月发布电信运营商液冷技术白皮书,提出 25 年及以后液冷在 50%以上项目规模应用的愿景),总结来看,液冷同时受到上游芯片端、服务器端、下游 IDC 端、运营商端协同推进,有望提振液冷设备及新型液冷数据中心建设需求。根据 DellOro预测,到 2027 年全球液冷市场规模将接近 20 亿美元。

(二)GH200与GB200的基本介绍

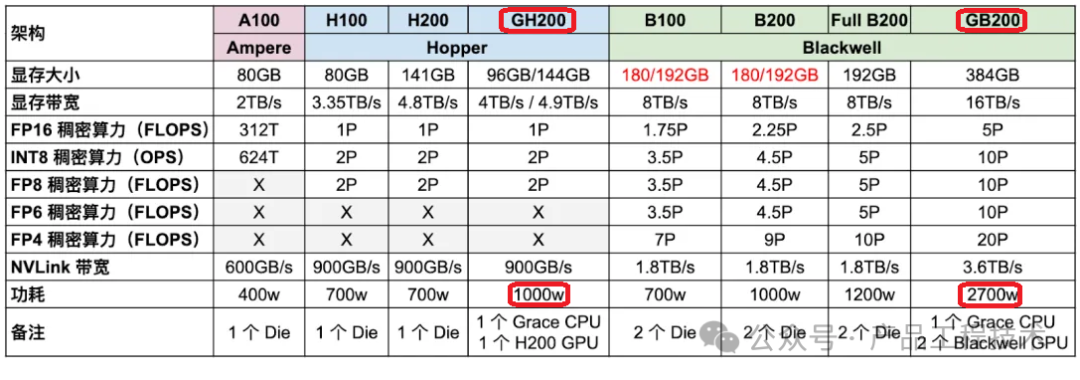

通过与GH200各项参数的对比来介绍GB200,可能更为清晰和直观。

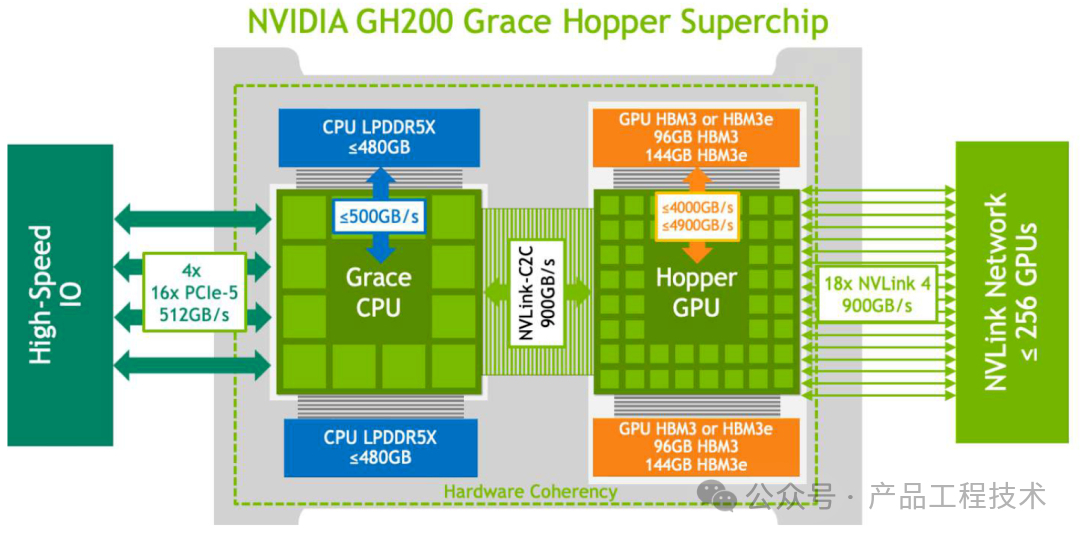

GH200 是 NVIDIA 2023年发布的 H200 GPU 与 Grace CPU 的结合体,一个 Grace CPU 对应一个 H200 GPU,H200 GPU 的显存可以达到 96GB 或 144GB。Grace CPU 和 Hopper GPU 之间通过 NVLink-C2C 互联,带宽为 900GB/s。对应的功耗为 1000w。

GH200硬件架构

NVIDIA GH200 Superchip

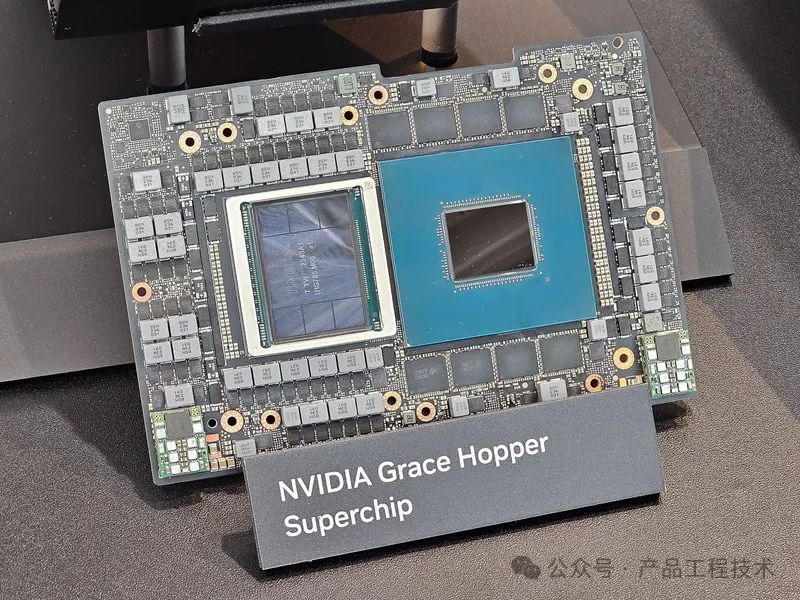

2024年3月19日,英伟达在年度GTC上推出了最强AI芯片GB200,性能相较于H100,GB200的算力提升了6倍,在处理多模态特定领域任务时,其算力更是能达到H100的30倍。能耗却降低了25倍。和 GH200 不同,一个 GB200 由1 个 Grace CPU 和2 个 Blackwell GPU 组成,相应的 GPU 算力和显存都加倍。CPU 和 GPU 之间依然通过 900GB/s 的 NVLink-C2C 实现高速互联。对应的功耗为 2700W。

GB200硬件架构

NVIDIA GB200 Superchip

GH200与GB200主要性能参数对比

GB200的功耗达到了2700W,这么高的功耗对散热的需求非常高,GB200 NVL72是一个多节点液冷机架级扩展系统,适用于高度计算密集型的工作负载。

(三)各厂商液冷服务器及液冷机柜

GB200 主要有2种机柜形态:

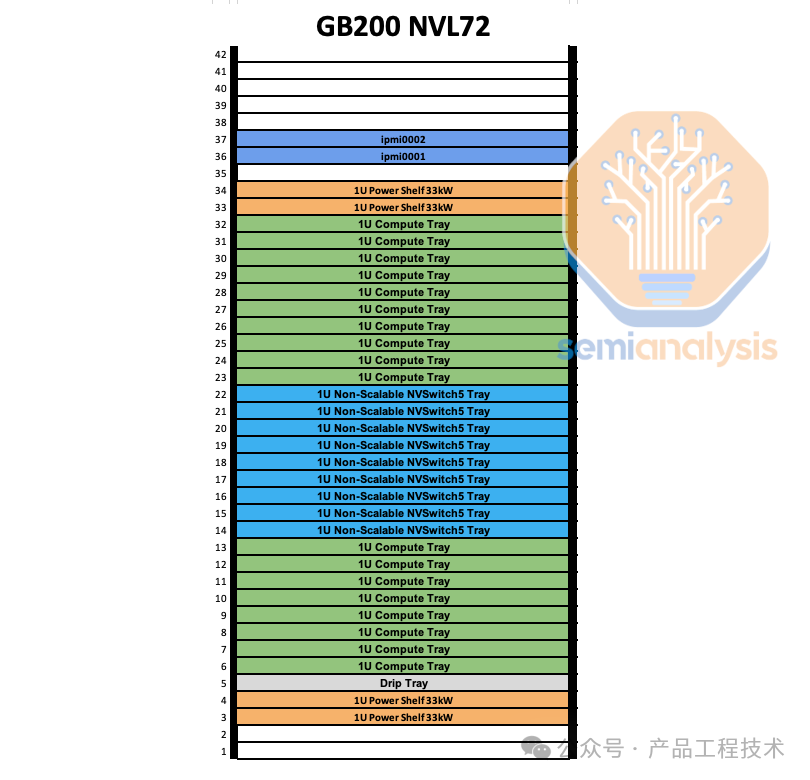

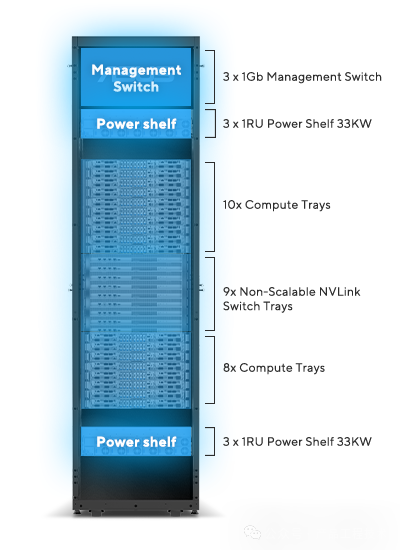

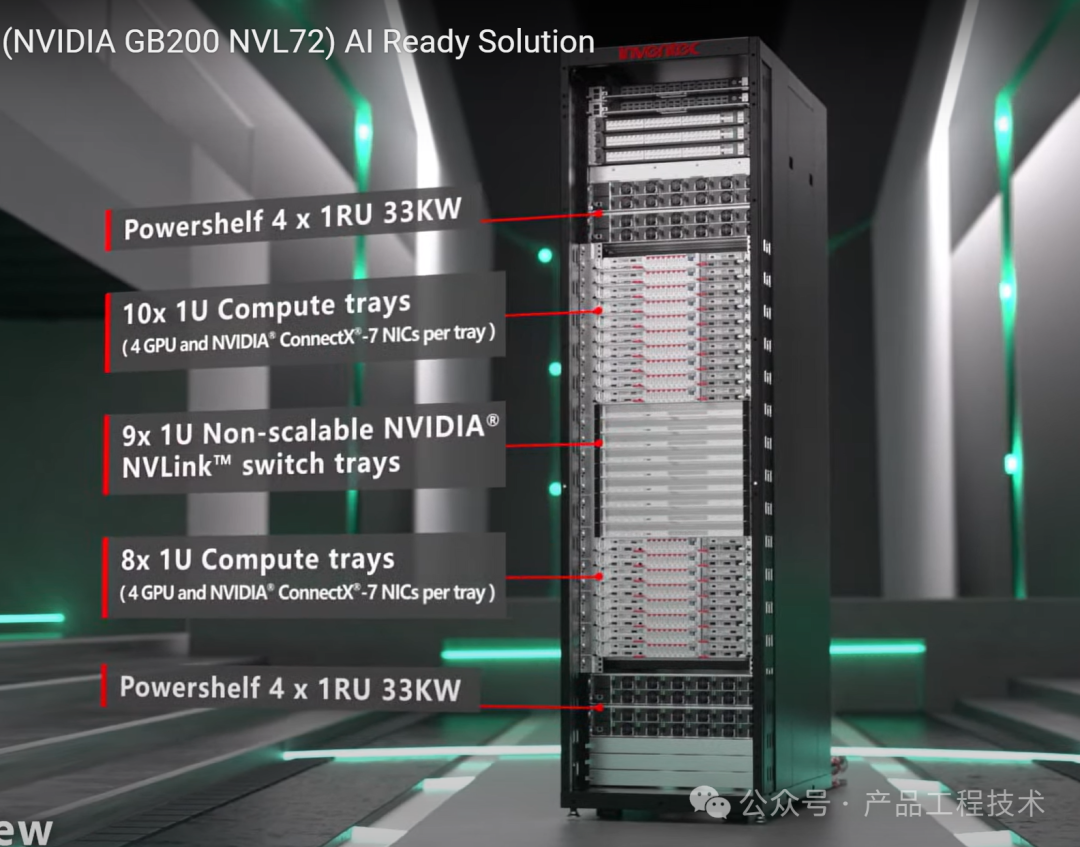

GB200 NVL72(10+9+8布局方式)

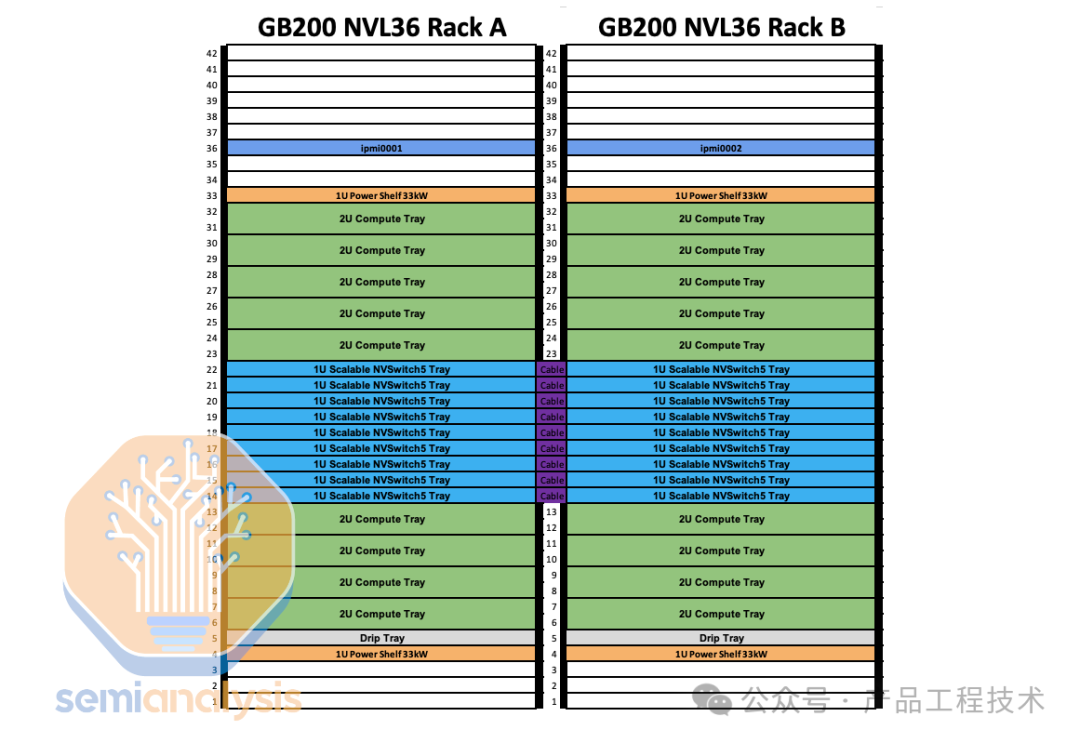

GB200 NVL36x2(5+9+4布局方式)

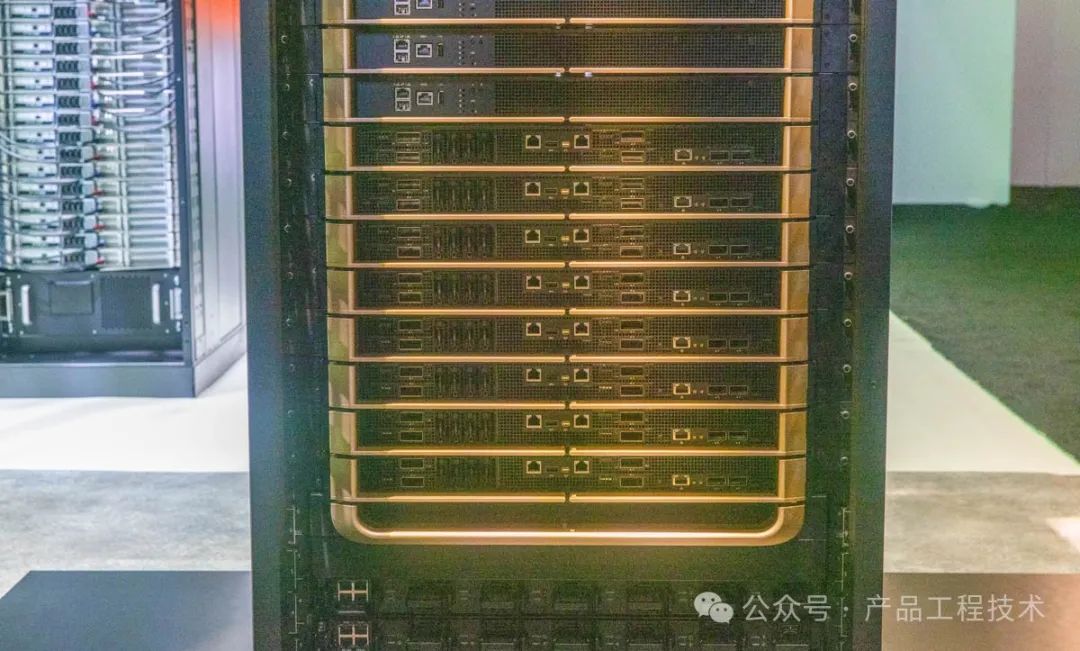

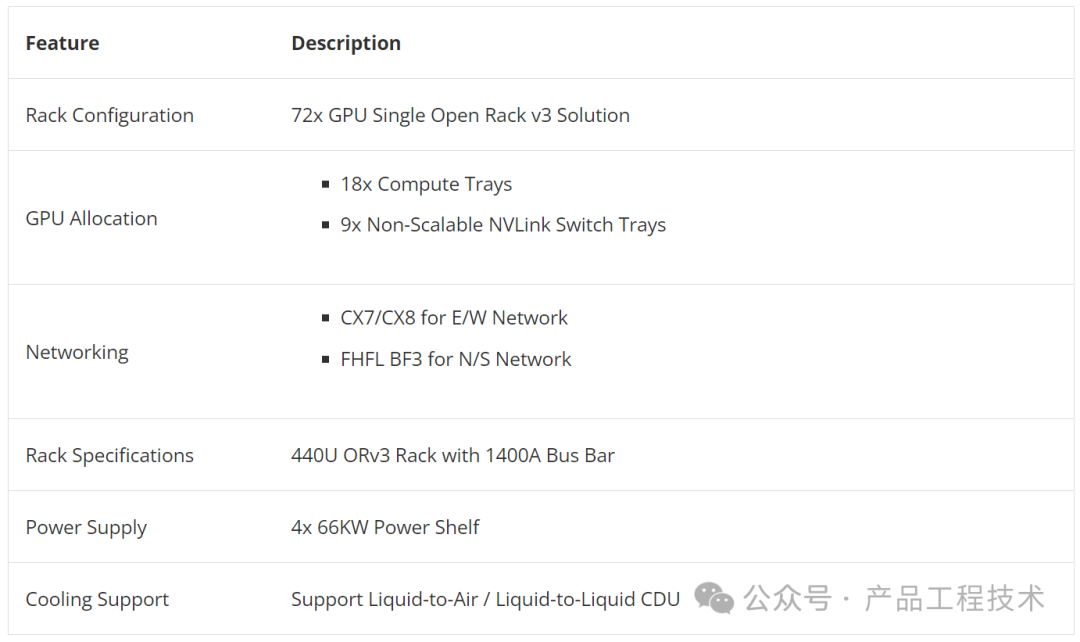

第一种是GB200 NVL72机柜,整个机柜功率大约120kW。目前通用CPU机柜支持高达12kW/机架,而更高密度的H100 风冷机柜通常仅支持大约 40kW/机架。一般对于单机柜超过30kW就应该考虑使用液冷,因此GB200 NVL72机柜采用的是液冷方案。

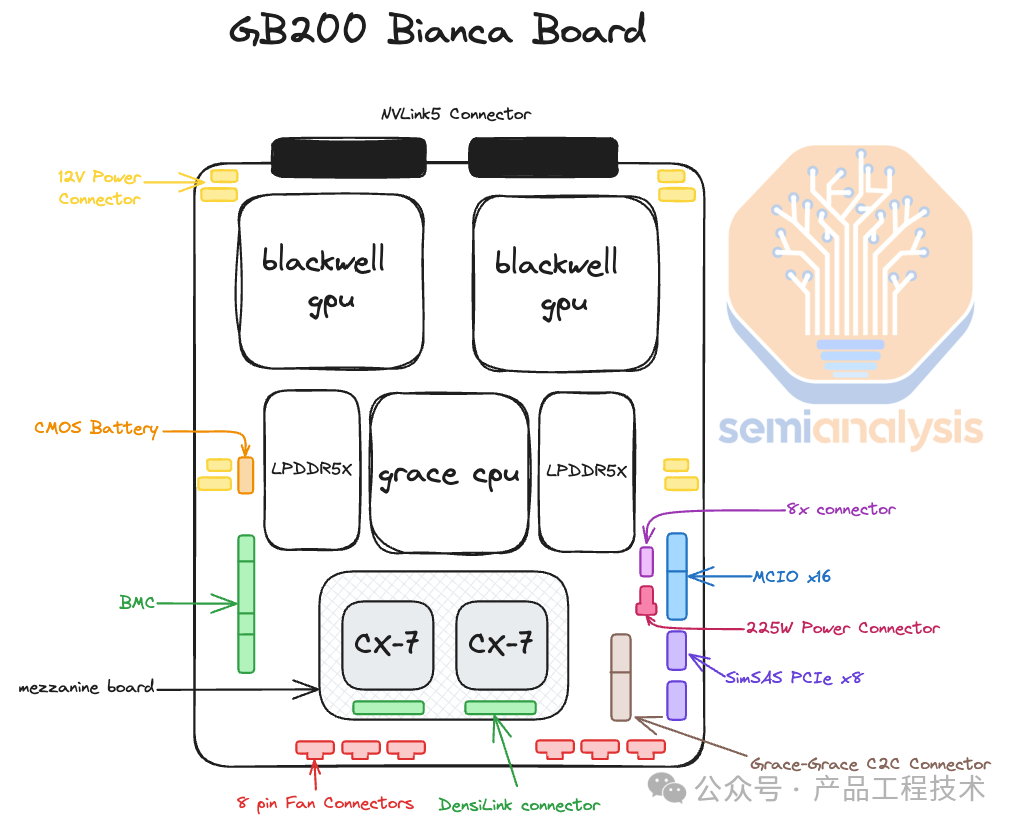

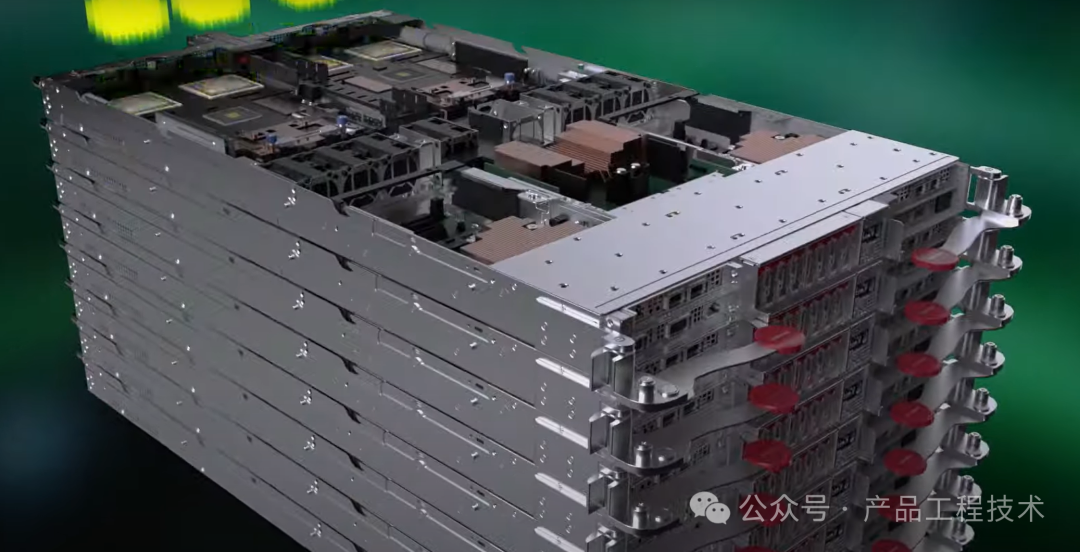

GB200 NVL72 机柜的组成:由18 个 1U 计算节点+ 9 个 NVSwitch 组成。每个计算节点高 1U,包含 2 个 Bianca 板。每个 Bianca 板包含 1 个 Grace CPU 和 2 个 Blackwell GPU。NVSwitch 托盘有两个 28.8Gb/s NVSwitch5 ASIC。

这个形态的机柜目前很少被部署,因为大多数数据中心基础设施即使采用直接芯片液体冷却 (DLC) 也无法支持如此高的机架密度。

GB200 NVL72机柜布局

另一种机柜形态是GB200 NVL36 * 2 ,它是由两个并排互连在一起的机柜组成。目前大多数 GB200 机架将使用此结构形态。每个机架包含 18 个 Grace CPU 和 36 个 Blackwell GPU。在这2个机柜之间,保持非阻塞的全互联,支持NVL72中所有72个GPU之间的互通。每个计算节点的高度为2U,包含2个 Bianca 板。每个NVSwitch 托盘都有两个28.8Gb/s NVSwitch5 ASIC 芯片。每个芯片有 14.4Gb/s 指向背板,14.4Gb/s 指向前板。每个 NVswitch 托盘有 18 个 1.6T 双端口 OSFP 笼,水平连接到一对 NVL36 机架。

GB200 NVL36 * 2机柜布局

在2024台北国际电脑展期间公开亮相的GB200 NVL72当中,外型大同小异,多数厂商现场展出的是单机柜形态:例如,緯穎、永擎、技嘉、美超微、英業達,大多搭配1U尺寸的運算節點伺服器,其中,技嘉、英業達、和碩均展出搭配2U尺寸的運算節點伺服器,廠商們將這樣的配置稱為GB200 NVL36。

接下来针对各家做的GB200液冷服务器和液冷机柜进行分别介绍。

英伟达

超微

鸿海

广达

维颖

华硕

英业达

(1)英伟达 NVIDIA

下面是单个机架120kW的旗舰系统。目前,大部分数据中心最多可以支持60kW机架,对于那些无法部署单机架120kW或8x机架SuperPOD接近1MW的用户,可以采用上述NVL36x2机柜形态。

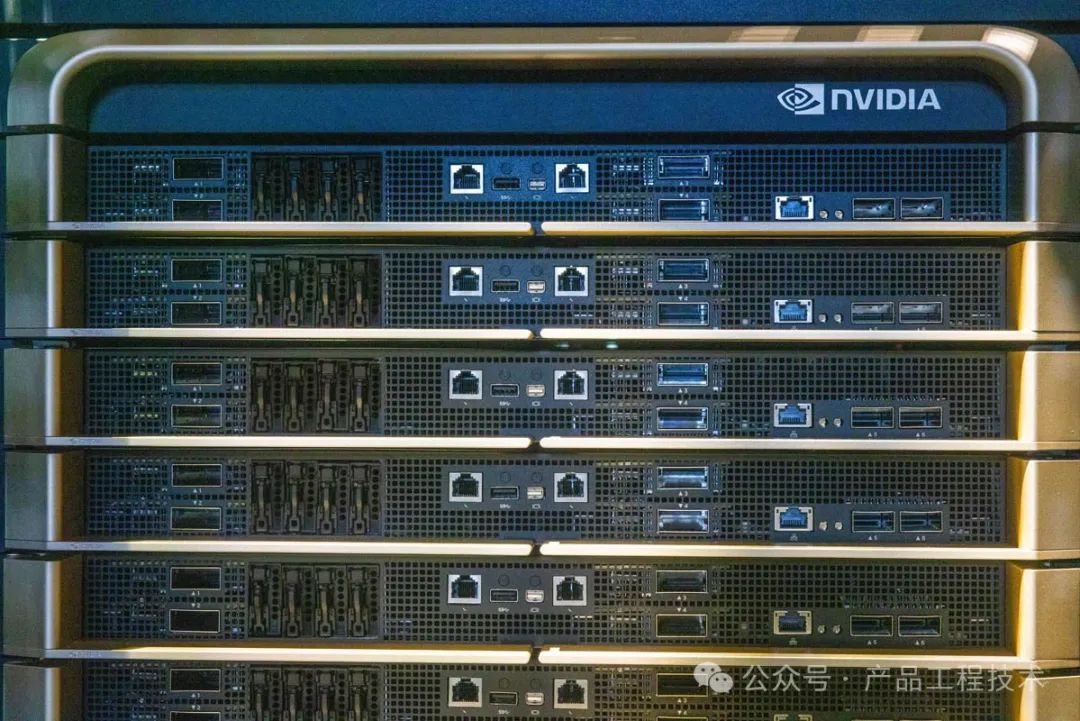

NVIDIA DGX GB200 NVL72 正面

在机柜的最顶端有2台 52 口(48个千兆RJ45口 +4个QSFP28 100Gbps 聚合端口) Spectrum 交换机 。这2台交换机用于管理和传输来自组成系统的各个计算节点、NVLink 交换机和电源框的各类数据。

这2台52口交换机正下方是整个机柜6个电源框中的3个,另外3个位于机柜的底部。这些电源框负责为 120kW 机柜提供电力。据估算,6个 415V、60A 的 PSU 足以满足这一要求。但是在设计中考虑了一定程度的备份冗余。这些电源的运行电流可能超过 60A。每台设备的供电通过机柜后面的Bus Bar完成。

NVIDIA DGX GB200 NVL72 交换机

在上部3个电源框的下面有10个1U的计算节点。在节点的前面板有四个 InfiniBand NIC(前面板左侧和中央的四个QSFP-DD 笼),它们构成了计算网络。系统还配备了 BlueField-3 DPU,据说它负责处理与存储网络的通信。除了几个管理端口外,还有4个 E1.S 驱动器托盘。

NVIDIA DGX GB200 NVL72 顶部计算节点

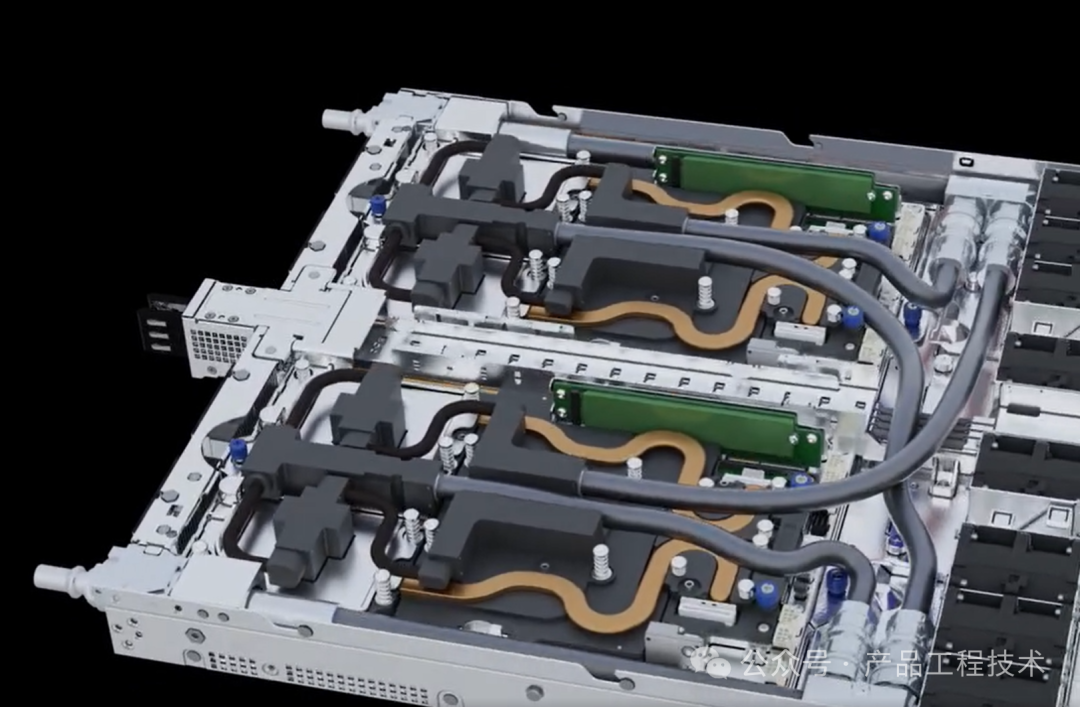

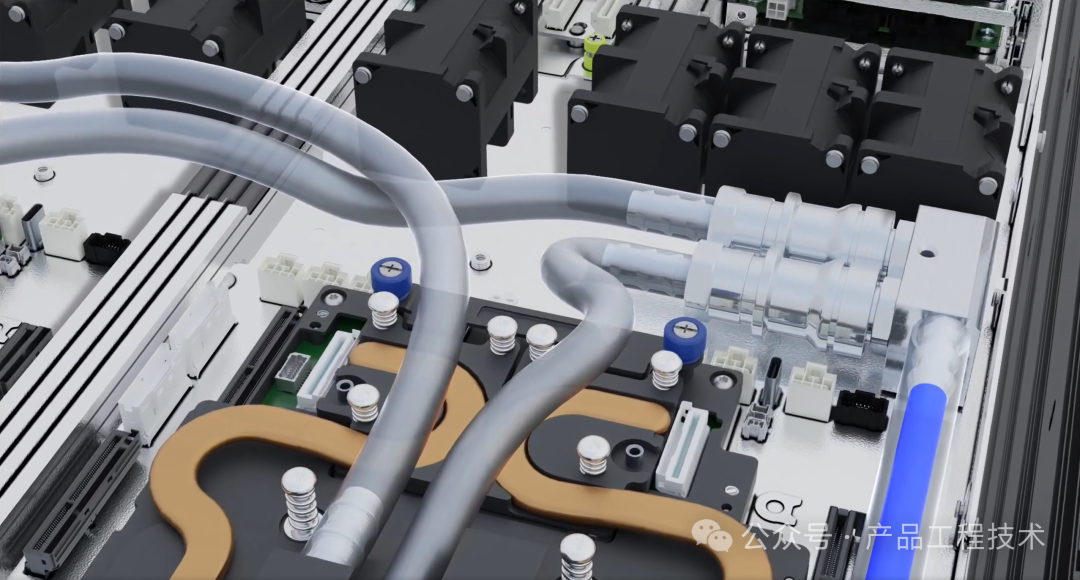

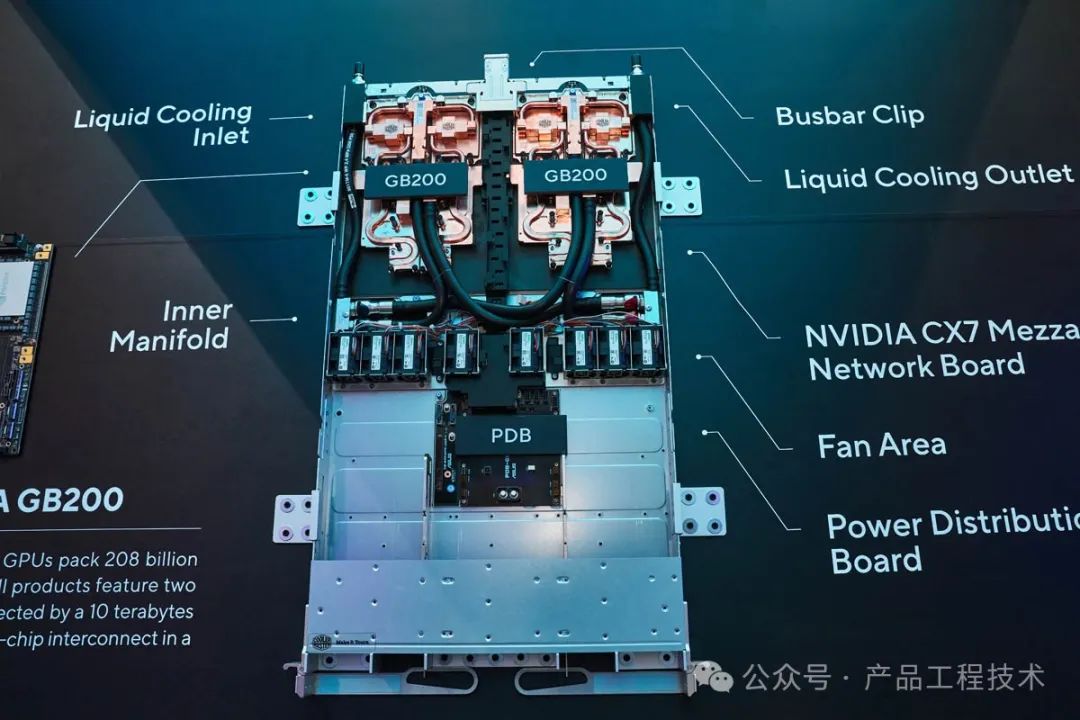

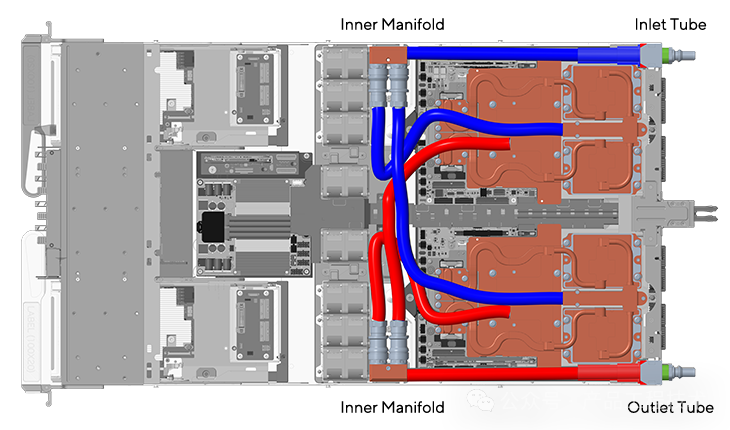

每个计算节点都有两个 Grace Arm CPU。每个 Grace 都连接到每个计算节点的两个 Blackwell GPU。每个节点的功耗在 5.4kW ~5.7kW 之间。绝大部分热量通过直接到芯片 (DTC) 液体冷却带走

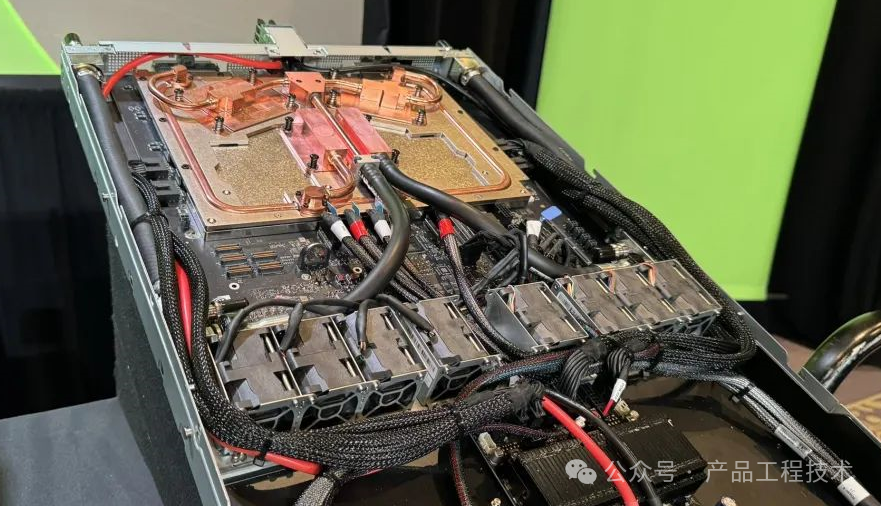

下面是计算节点带有液冷模块和不带液冷模块的内部视图。

NVIDIA DGX GB200 NVL72 计算节点内部

NVIDIA DGX GB200 NVL72 计算节点液冷部分

Nvidia 展示的来自联想的没有安装冷板的GB200原型系统

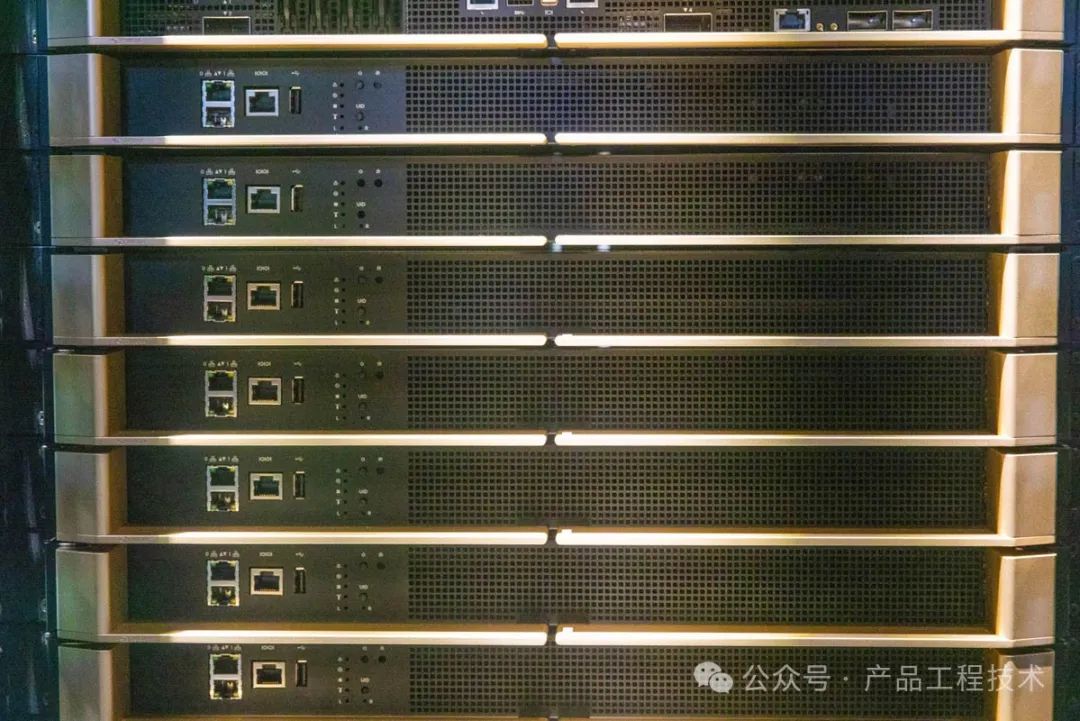

位于顶部10个计算节点下方的是9台 NVSwitch交换机。面板上的金色部件是用于插拔交换机的手柄。

NVIDIA DGX GB200 NVL72 NVSwitch 前端

NVLink Switch 内部有两个 NVLink 交换机芯片,也采用液冷方案。

NVIDIA DGX GB200 NVL72 交换机内部

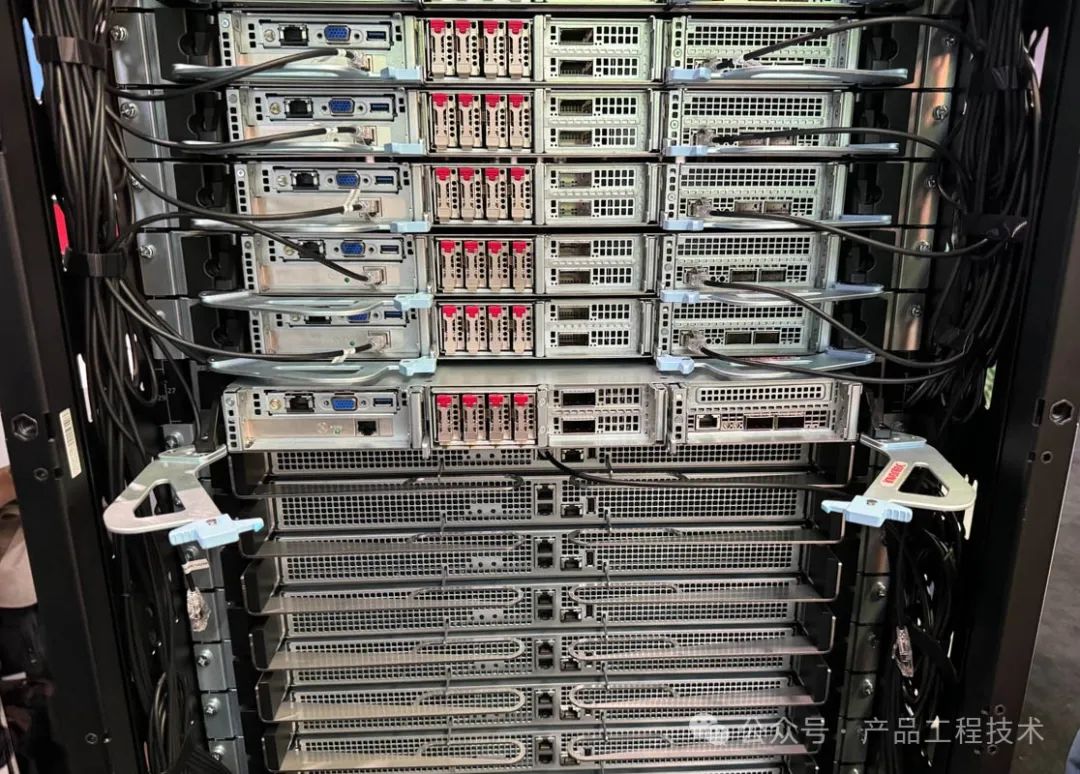

在机柜的底部,即是9台 NVSwitch交换机的下方,有8个1U的计算节点。

NVIDIA DGX GB200 NVL72 底部计算节点

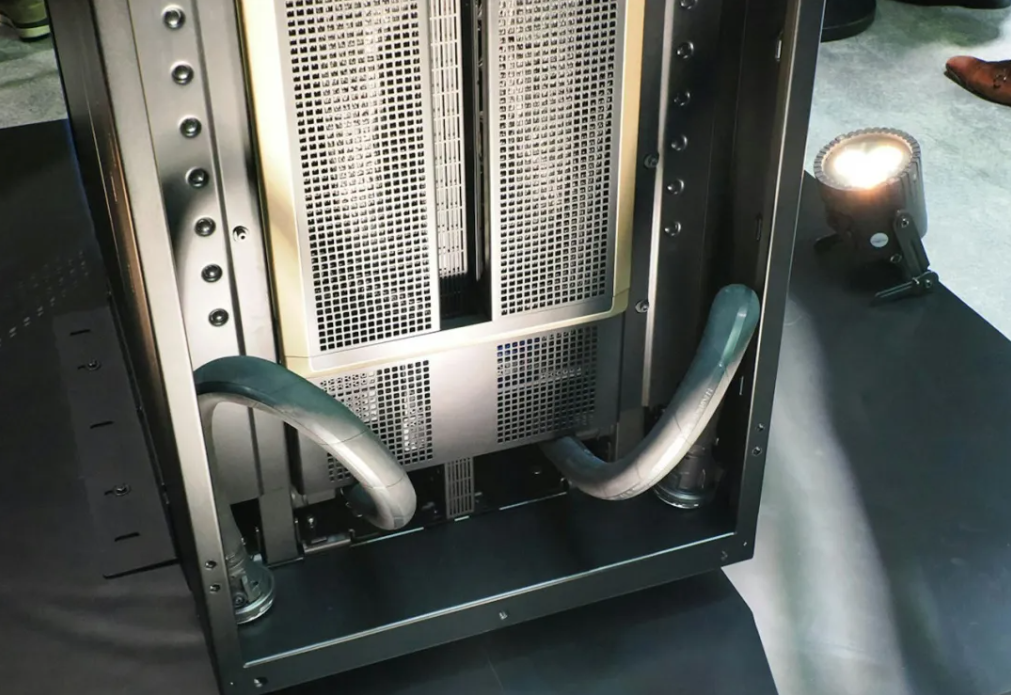

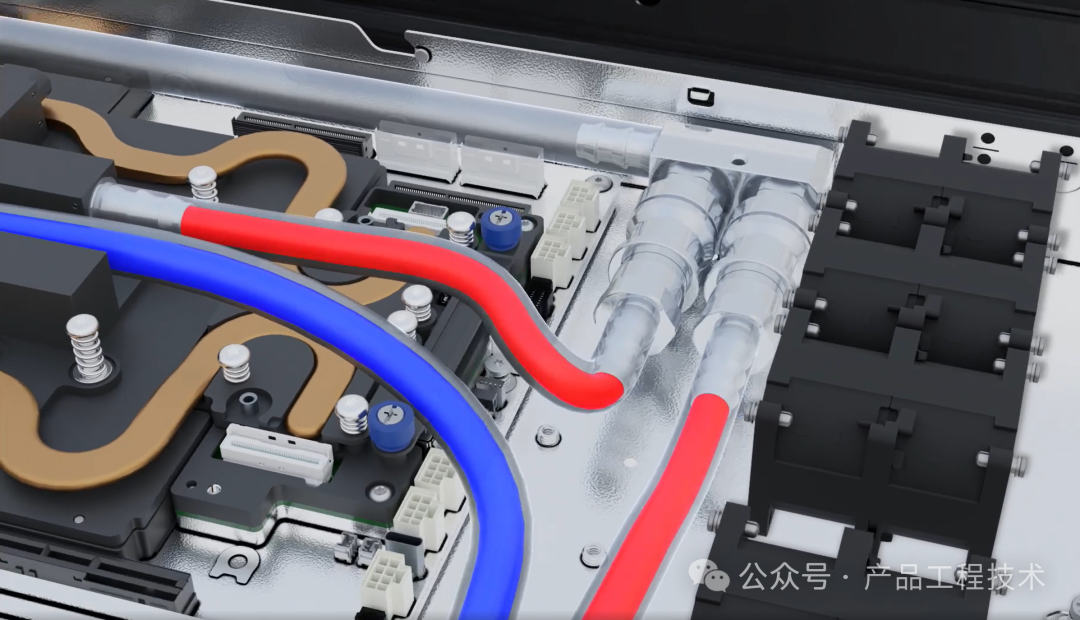

在机柜的后面,机柜采用盲插的Bus Bar供电设计,以及为每个设备提供冷却液体的插头和 NVLink 连接。每个部件都需要留出一定的活动空间,以确保盲插的可靠性。

NVIDIA DGX GB200 NVL72 后面

据黄仁勋介绍,冷却液以2L/s的速度进入机架,进入机柜的温度为 25℃,流出机柜的温度会超过 20℃。

NVIDIA DGX GB200 NVL72 后面底部进出液体的管路

NVIDIA 表示,在机柜后部使用铜缆(光纤)NVLink每柜可以节省大约20kW的电力。所有铜缆的长度预计超过 2 英里(3.2公里)。这也解释了为什么 NVLink 交换机位于机柜的中间位置,因为这样做可以使电缆长度保持在最短。

NVIDIA DGX GB200 NVL72 NVLink Spine Without Optics

(2)超微Supermicro

Supermicro NVIDIA MGX™ Systems

1U NVIDIA GH200 Grace Hopper™ Superchip Systems

(3)鸿海Foxconn

2024年3月18日,在英伟达的GTC大会上,鸿海集团子公司鸿佰科技(Ingrasys)发布一款使用英伟达GB200芯片的NVL72液冷服务器,该服务器集成了72个英伟达Blackwell GPU和36个英伟达Grace CPU。

黄仁勋以及鸿海、拥有不错的交情,双方在服务器等方面有多个合作,而旗下最新超级AI服务器DGX GB200也即将在下半年开始量产,而GB200系列产品将以Rack形式出货,目前粗估的订单量就高达5万柜。鸿海目前已手握DGX GB200系统机柜三大类新品(分别为:DGX NVL72、NVL32、HGX B200),可说是是平台世代交替的大赢家。

新一代 AI 液冷机架解决方案 NVIDIA GB200 NVL72,结合了 36 个 NVIDIA GB200 Grace Blackwell 超级芯片,其中包括 72 个基于 NVIDIA Blackwell 的 GPU 和 36 个NVIDIA Grace CPU ,它们通过第五代NVIDIA NVLink互连,形成单个大型 GPU。

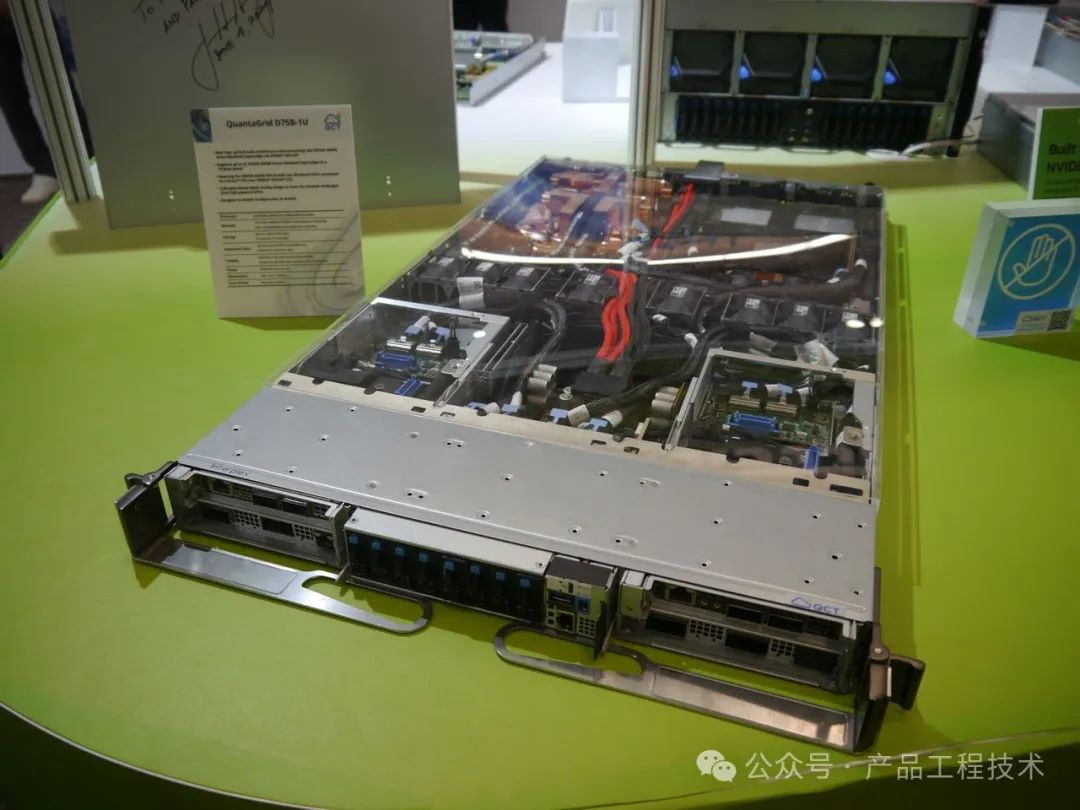

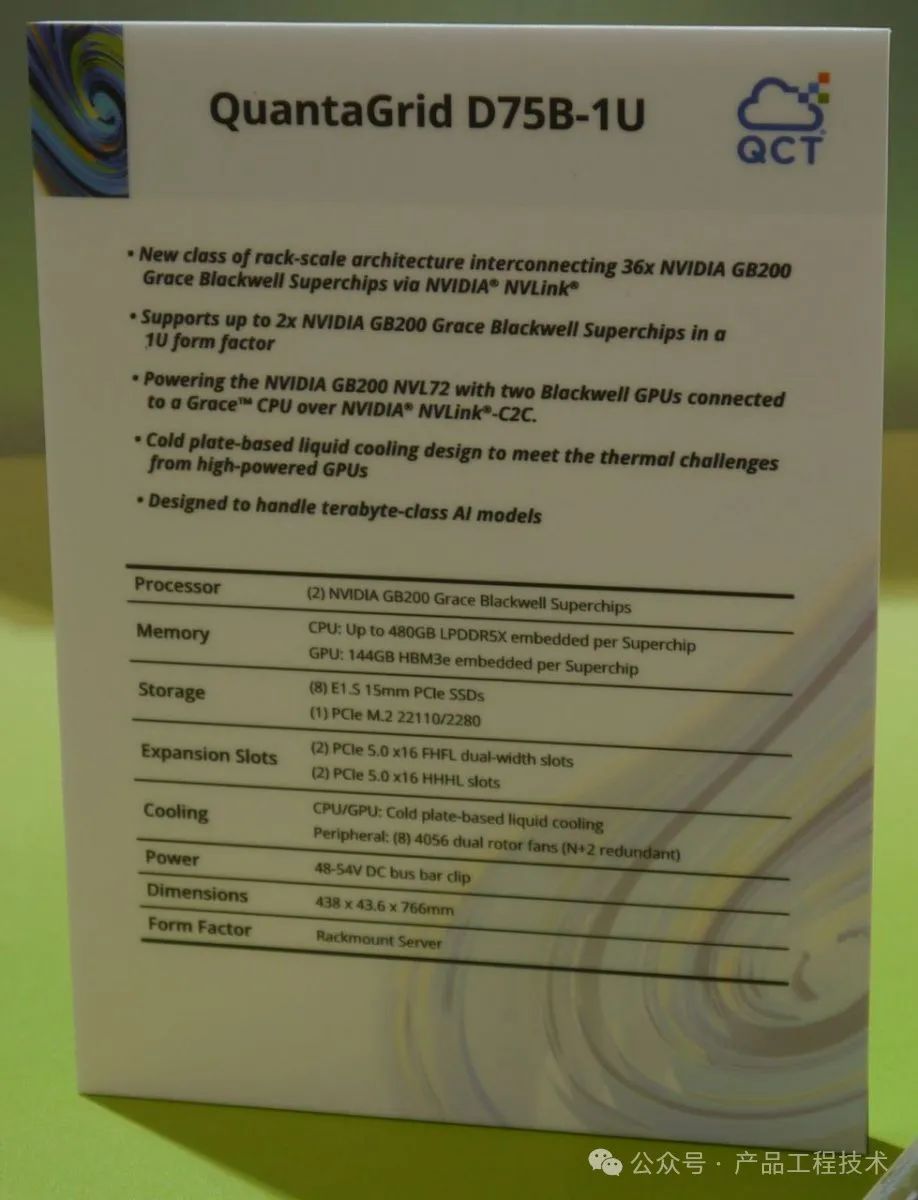

(4)云达科技(广达)QCT

云达科技现场展示的1U机型QuantaGrid D75B-1U,在Nvidia GB200 NVL72的系统建置框架之下,可透过单座机柜容纳72台这样的设备。D75B-1U本身搭载2张GB200 Grace Blackwell Superchip,云达在此标明CPU可存取480 GB容量的LPDDR5X记忆体,GPU本身配备144GB容量HBM3e高频宽记忆体,均搭配冷水板(Cold Plate)形式的液态冷却配件;储存装置方面,这台1U服务器可容纳8台E1.S厚度15mm外形的PCIe固态硬盘,以及1张M.2 2280外形的PCIe固态硬盘;在PCIe装置扩充方面,D75B-1U可容纳2张双宽全高全长尺寸的介面卡,以及2张半高半长尺寸的介面卡,均支援PCIe 5.0 x16。

(5)维颖Wiwynn

作为 NVIDIA 的重要合作伙伴,Wiwynn是首批符合NVIDIA GB200 NVL72标准的公司之一。Wiwynn 在 GTC 2024 上展示了其最新的AI 计算解决方案。新发布的NVIDIA GB200 Grace™Blackwell超级芯片支持最新的NVIDIA Quantum-X800 InfiniBand和NVIDIA Spectrum™-X800以太网平台。其中包括由NVIDIA GB200 NVL72 系统驱动的新型的机架级液冷AI服务器机架。Wiwynn充分利用其在高速数据传输、能源效率、系统集成和先进冷却技术方面的优势。其目标是满足客户对数据中心生态系统中性能、可扩展性和多样性的新兴需求。

Wiwynn GB200 NVL72 机架解决方案

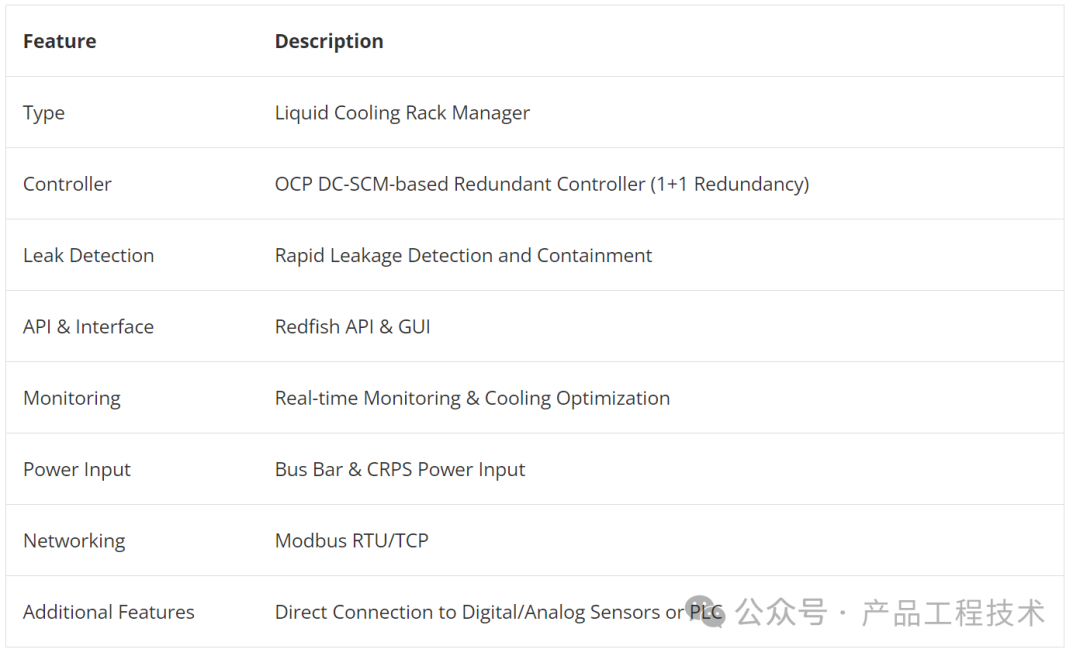

Wiwynn 还推出了 UMS100(universal liquid-cooling management system),这是一款先进的机架级液冷管理系统,旨在满足新兴生成式人工智能 (GenAI) 时代对高计算能力和高效冷却机制日益增长的需求。这款创新系统提供一系列功能,包括实时监控、冷却能量优化、快速泄漏检测和遏制功能。它还旨在通过 Redfish 接口与现有数据中心管理系统顺利集成。它支持行业标准协议,可与各种冷却分配单元 (CDU) 和侧柜兼容。

Wiwynn UMS100 通用冷却管理系统

以下为宣传图片。

以下为2024 GTC现场图片。

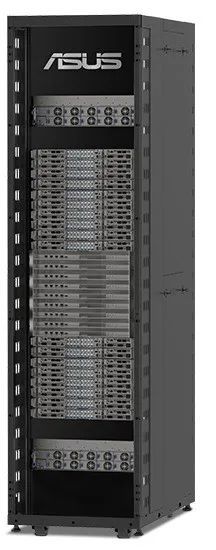

(6)华硕ASUS

在 2024 年台北国际电脑展上,华硕推出的多款 AI 服务器。其中包括新款 NVIDIA Blackwell 服务器,包括 B100、B200 和 GB200 服务器以及 AMD MI300X 服务器。甚至还有 Intel Xeon 6 服务器以及拥有高达 500W CPU TDP 的 AMD EPYC Turin 服务器。

最重要的是华硕 ESC AI POD,它是该公司的NVIDIA GB200 NVL72版本。

华硕 NVIDIA GB200 NVL72

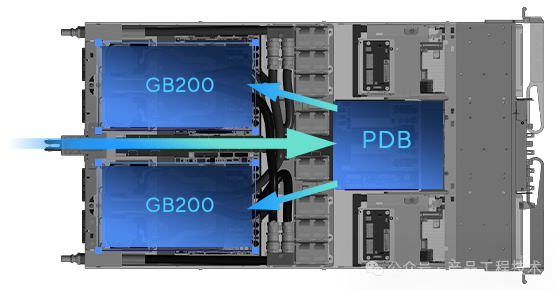

华硕还展示了其中一个节点的外观。我们可以看到 1U 机箱中的母线电源和双液冷 GB200 节点。节点里面配备2张GB200 Grace Blackwell Superchip,上面均覆盖冷水板,而在机箱中间有个他们设计的电源配送板(Power Distribution Board,PDB),可将48伏特直流电转换为12伏特直流电,供应Blackwell GPU使用;除此之外,这个运算槽还搭配可安装E1.S外形固态硬盘的存储模块,以及两张BlueField-3数据处理器系列的双宽全高半长款式B3240。

华硕 ESC AI POD 计算节点设计

对于那些想要低成本 Arm 计算和 NVIDIA GPU 的用户,有一个双 NVIDIA Grace Hopper GH200 平台,即华硕 ESC NM2-E1。它将两个 Grace Hopper CPU 和 GPU 组合单元放入一个系统中。

华硕 ESC NM2 E1

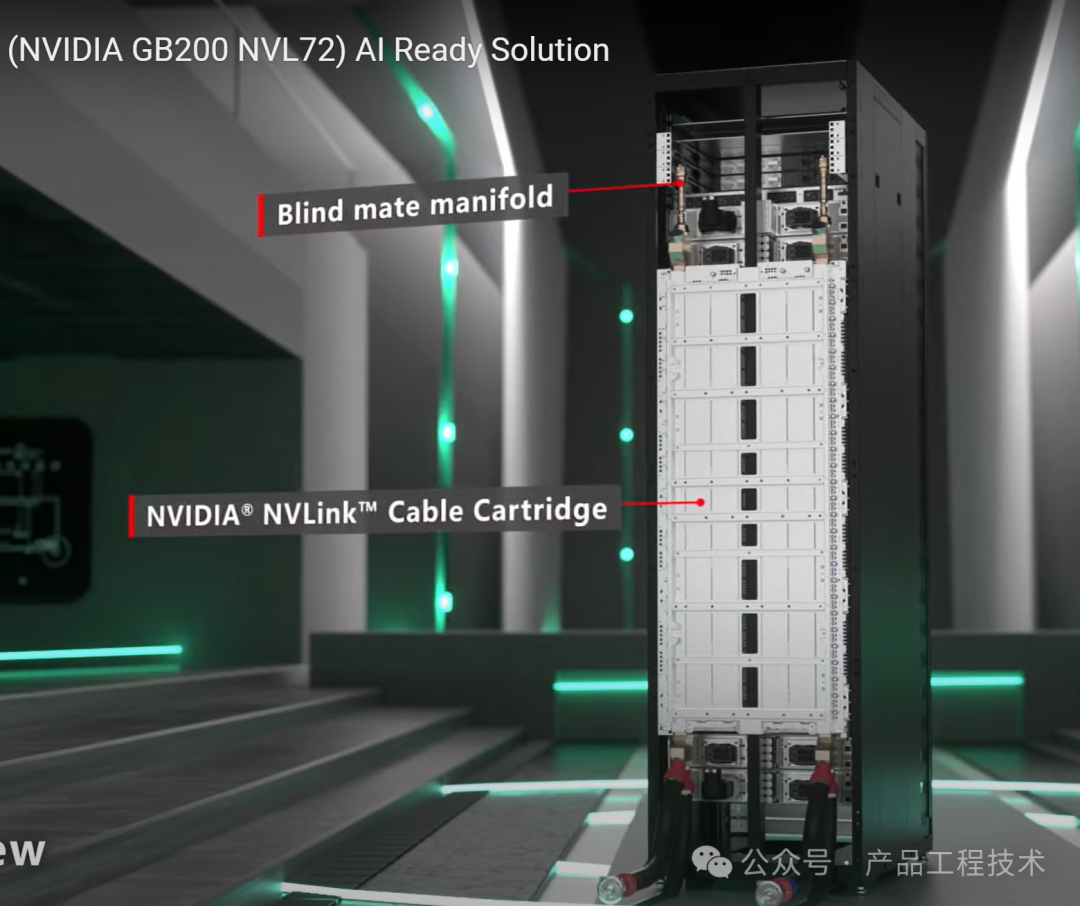

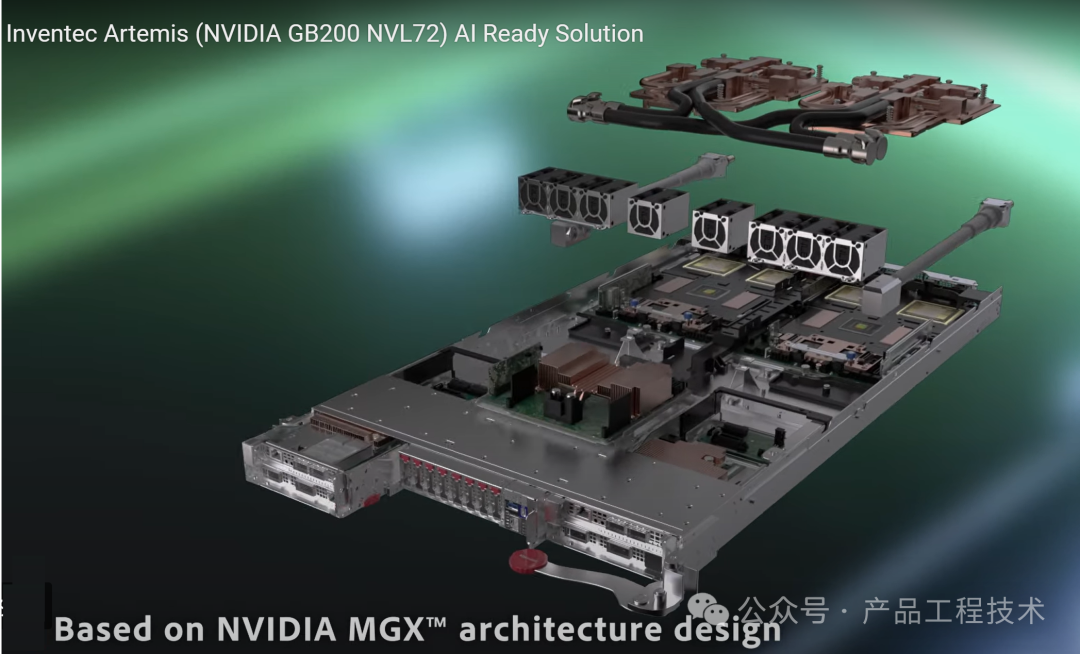

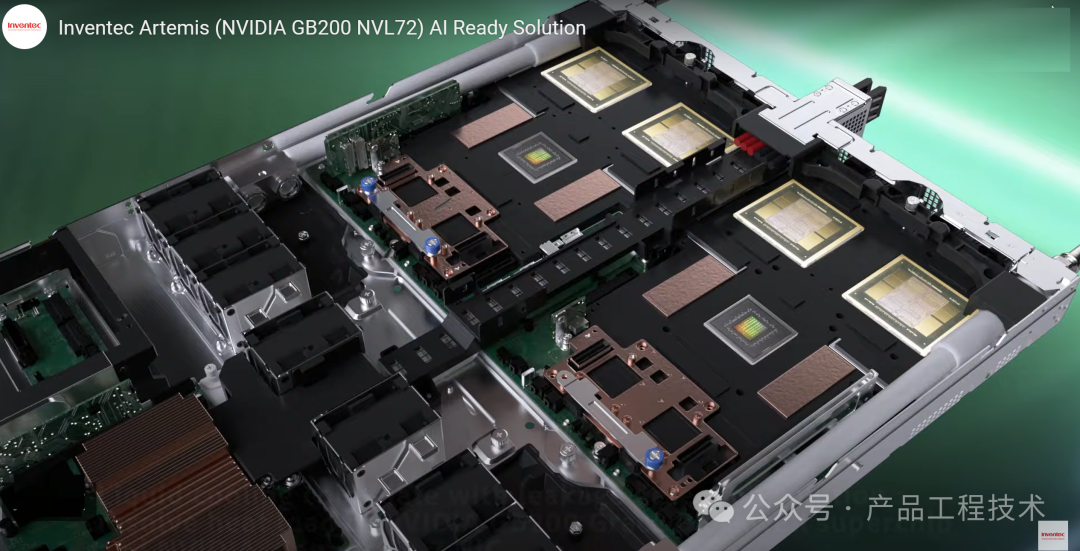

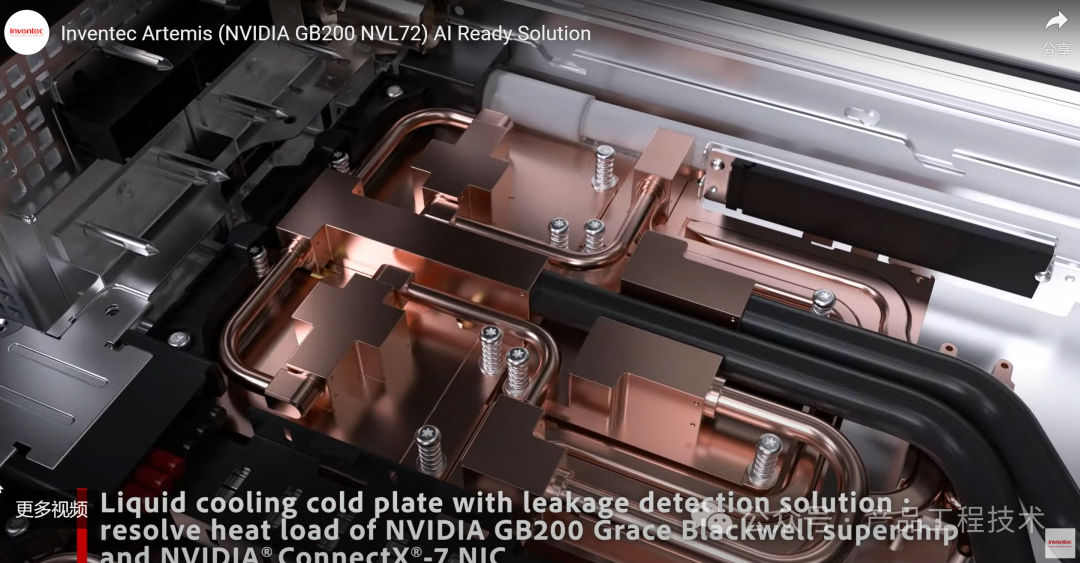

(7)英业达Inventec

120kW每柜 Power Bus Bar—1400A 8*33kW power shelves—1+1备份

液冷盲插+bus bar盲插+通信盲插

机柜后部

服务器机柜搭配一座称为侧车(Side Car)的冷却机柜(编按:所谓的侧车是一种液态冷却机柜搭配服务器机柜的部署形式,应该是借用两轮机车侧边加装附有单轮乘坐设备的比喻)。

来源:产品工程技术

①凡本网注明"信息来源:热传商务网"的所有文章,版权均属于本网,未经本网授权不得转载、摘编或利用其它方式使用。

②来源第三方的信息,本网发布的目的在于分享交流,不做商业用途,亦不保证或承诺内容真实性等。如有侵权,请及时联系本网删除。联系方式:7391142@qq.com

热传商务网-热传散热产品智能制造信息平台

热传商务网-热传散热产品智能制造信息平台