随着互联网、云计算和大数据业务的增多,数据中心的总能耗越来越大,其能源效率也越来越受到重视。据数据统计,我国数据中心平均能源利用效率PUE(Power Usage Effectiveness)值为1.49,远高于国家发改委提出的新建大型数据中心小于1.25的要求。

降低PUE迫在眉睫,网络设备厂商要如何在保障芯片高性能表现的同时下大幅降低能耗?散热系统作为同时影响性能和能耗的关键因素成为数据中心改革的重点,而液冷技术由于其独特优势,正逐步取代传统风冷成为主流散热方案。本文将从政策和芯片角度剖析数据中心交换机引入液冷技术的必要性,就液冷技术不同方案的差异化,探讨锐捷在冷板式液冷交换机和浸没式液冷交换机的研发经验及成果。

能耗与政策角度

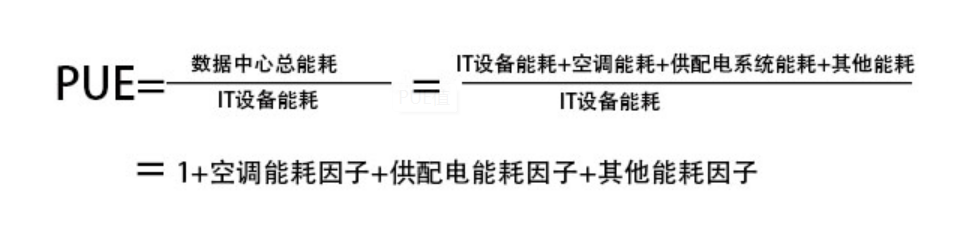

PUE值是数据中心总能耗与IT设备能耗之比,PUE值越接近1,说明非IT设备耗能越少,能效水平越好,数据中心的绿色化程度越高。

图1 PUE用来评价数据中心能源效率

由数据中心的平均能耗组成(图2),我们发现在数据中心能耗占比中,散热系统能耗平均高达33%,接近数据中心总能耗的三分之一,这是因为传统数据中心采用的风冷散热系统是以比热容很低的空气作为载冷媒介,通过设备内的风扇驱动,把CPU等热源传导给散热器的热量从IT设备带走,再利用风机盘管换热器或空调制冷等方式循环对空气进行散热降温,这也是风冷散热的局限必然。由此,如何解决散热系统的用能效率,成为新政策环境下设备厂商面临的技术迭代挑战。

图2 数据中心能耗组成

芯片散热需求角度

从设备芯片散热需求角度。随着交换机芯片发展,虽然高性能芯片工艺制程(如5nm)可有效降低单位算力功耗,但随着交换芯片的带宽增大到51.2Tbps,单芯片的总功耗已经攀升至900W左右,如何解决设备芯片的散热问题成为整机硬件设计的难点。虽然目前风冷散热系统尚可支撑运转,但当芯片热流密度(单位时间通过单位面积的热量)大于100W/cm²时,难题便接踵而来:

首先,散热器热阻的进一步降低遭遇瓶颈。散热器为了能够化解小芯片近千瓦的发热功率,需要使用总热阻更低的架构方式。这也意味着,如果散热器的能力提升想要平衡芯片的功耗增加,就需要更优质的导热材质和散热器设计,但目前高性能风冷散热器的设计和加工大都已经获得了热管、均温板和3D VC的加持,已经接近性能优化的极限。

其次,受限于交换机产品的高度要求,很难通过扩大散热器体积来解决散热问题。这是因为热量从芯片出发,突破芯片外壳、热界面材料、均温板、焊料、热管等,最终却卡在了固气的界面翅片。又由于翅片与空气间的对流换热系数低,为了凑齐高功率芯片散热所需的散热面积,热设计工程师不得不将散热器的尺寸不断扩大,几乎填满了服务器和交换机内的可用空间。可以说,风冷散热的最终瓶颈是其翅片式结构对空间的刚需。此外,为了增大风量,风扇转速已经到了3万转,飞机起飞般的噪音深深困扰着开发和运维人员。

最后,在芯片功耗仍不断攀升的情况下,风冷系统的散热能力即将到达极限。即使风冷散热器可以解决目前交换机的散热问题,但到未来102.4/204.8Tbps成为主流、芯片功耗更大时,风冷散热器终将力不从心。因此,更高效能的面向下一代IT设备的液冷技术出现。未来5-10年,数据中心风冷散热会逐渐被液冷替代也成为业内共识。

液冷技术分类和优缺点

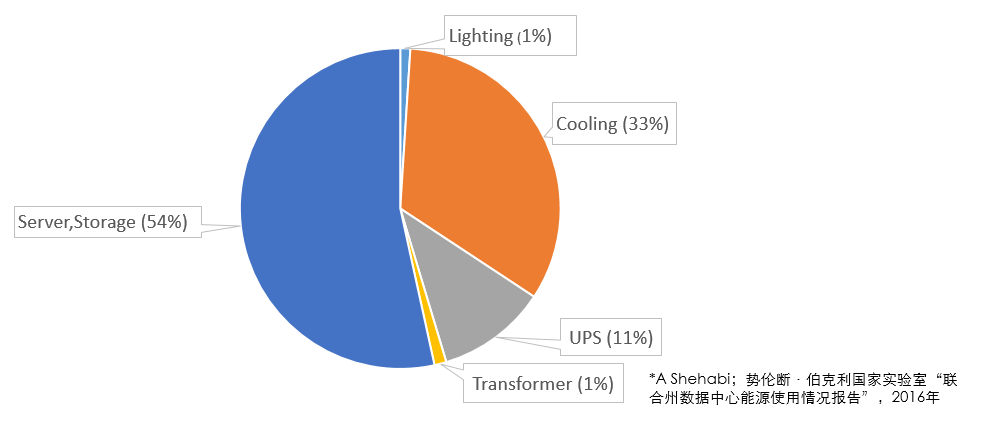

当前液冷技术主要分为单相液冷和两相液冷,锐捷在COBO的白皮书“Design Considerations of Optical Connectivity in a Co-Packaged or On-Board Optics Switch(CPO/OBO交换机光学连接性的设计考虑)”中,对数据中心IT设备的散热系统形式进行了全面的梳理和分类(图5)。单相液冷指冷却液在循环散热过程中始终维持液态,通过高比热容轻易带走热量。两相液冷指冷却液在循环散热过程中发生了相变,冷却液通过极高的气化潜热带走设备热量。相较而言,单相液冷复杂度更低更易实现,且散热能力足够支撑数据中心IT设备,是当前阶段的平衡之选。

图3 数据中心IT设备主要散热方式

单相液冷分为冷板式液冷和浸没式液冷。冷板式液冷将液冷冷板固定在设备主要发热器件上,依靠流经冷板的液体将热量带走达到散热的目的。其在国内外超算中已有不少应用案例,OCP委员会已经通过Open Rack V3.0支持Manifold的架构标准进行了推动布局。

浸没式液冷则是将整机直接浸没在冷却液中,依靠液体的自然或强制循环流动带走服务器等设备运行产生的热量。其在数字货币矿场和超算应用较多,也是近些年OCP、ODCC等组织探讨的热点,国内某大型云计算公司的数据中心已经进行了规模化部署。

浸没式液冷的优点包括:(1)由于冷却液直接接触设备,散热能力更强,器件超温风险更低;(2)浸没式液冷设备无需风扇,设备震动更少,硬件设备的使用寿命更长;(3)浸没式液冷的机房侧冷冻水供液温度高,室外侧更易散热,因此机房选址不再像风冷时代那样,如此受地区和气温限制。当然浸没式液冷也有缺点,包括改造成本高、安规要求高和承重要求高等。

对比来看,冷板式液冷优点包括:对整体机房的改动较少,只需要改动机架、液冷分配装置(Coolant Distribution Units,CDU)和供水系统。并且,冷板式液冷能使用更多种类型的冷却液,用量也比浸没式要少很多,所以前期投入成本更低。此外,冷板式液冷产业链更成熟,市场上可接受度更高。但冷板式也有一些局限,首先,液体管路和接头可能会有液体泄漏的风险,造成设备损坏和业务中断。并且,冷板只覆盖了设备主要元器件,其余部件还需要风扇散热,所以设备会保留部分风扇,因此机架机房仍需要保留对应的风冷散热能力。

综合来看,两种散热方式各有优劣,浸没式液冷略胜一筹。

浸没式液冷交换机研发经验

近年来,各大公司在浸没式液冷数据中心方案上展开探索,锐捷网络在研发浸没式液冷交换机中也积累了较多经验,主要体现在浸没式液冷交换机的结构外观、风扇剪裁、材质兼容、SI特性(信号完整性)四个方面:

1.结构外观

首先,最大的改变就是电源从交换机的后面板移动到前面板。面板接口为了装下两个电源,交换机宽度也从19英寸增加至21-23英寸。整体的印刷电路板(PCB)供电走线设计也会改变。

图4 交换机外观变化

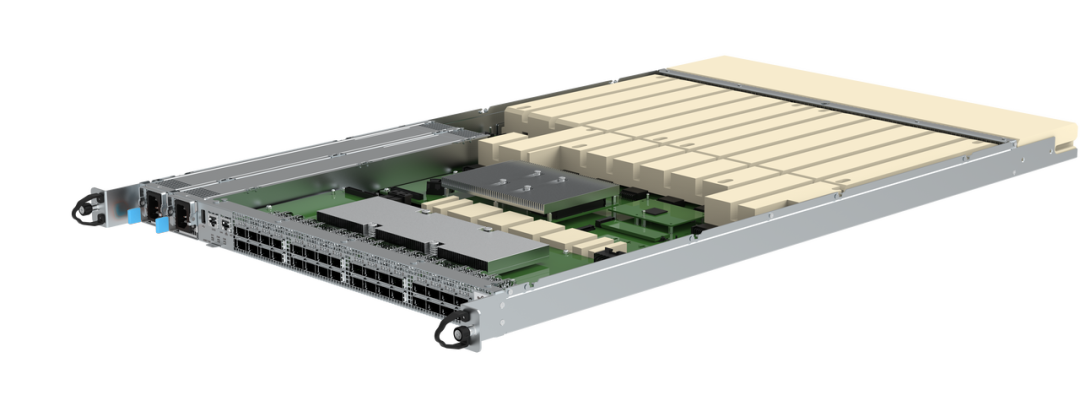

其次,设备的纵深会比传统交换机要长,最长可以达到800mm。这是由于冷却液费用高,为了尽可能节约冷却液的总使用量,多出来的空间用填充物占满,以达到在基于服务器定制的浸没箱中占据更多冷却液空间的目的。如图5所示,黄色块状物就是填充物,用于占液用。

图5 交换机结构进化

最后,设备两侧会增加滑轨以及前面板挂扣。这是由于机柜安装方式由水平放置变为竖直装入Tank机柜,增加这些变化方便吊装设备进行部署和维护。

2.风扇剪裁

结构改变也导致整体的风扇剪裁。设计师不仅不再需要为交换机设计设备风扇,还可以直接选择无风扇设计的电源。这样的改变不仅可以降低PUE值,而且还能大幅降低机房噪音。

3.材质兼容

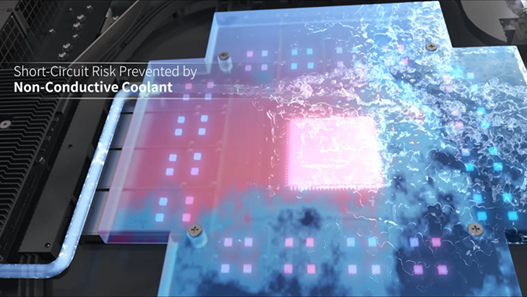

由于浸没式液冷的冷却液主要分为氟碳化合物和多种油类,交换机就要注意以下两点:(1)使用的光器件材料是否密封,如果未密封导致漏液,可能导致光路污染引发信号衰减和交换机故障;(2) 所有器件是否会和冷却液发生物理或化学反应,如果发生反应,原有交换机的某些器件的材料比例会发生变化,从而带来绝缘性改变等风险。因此,非金属结构件、各类电器件、TIM 材料、填充块、塑料拉手条、挂耳组件、标签、胶水、连接器、电缆及印刷电路板(PCB)等都要符合冷却液的兼容。

4.SI特性(信号完整性)

由于浸没式液冷交换机会与液体直接接触,SI(Signal Integrality,信号完整性)会受到液体影响。所以对PCB板有以下特殊的要求:(1)尽量规避关键型号走表层;(2)内层信号不受影响,低速信号走表层无需过多关注;(3)高速信号必须走表层,要提高阻抗设计;(4)BGA和连接器的扇出尽量减少表层走线长度;(5)25G和50G SerDes损耗设计和阻抗设计与传统有区别。

冷板式液冷交换机研发经验

锐捷网络基于硅光技术的特殊性,针对性地研发了冷板式液冷交换机(想要了解硅光技术的读者可以阅读上篇技术盛宴)。其中,OBO技术和NPO技术都是将光模块封装在主板上,尽可能离MAC芯片更近。然而,这会让热源过于集中,加之设备高度受限于设计要求期望的1RU高密形态,因此难以用传统的风冷散热器解决问题。如果采用浸没式液冷,光链路的密封性受到严峻挑战。

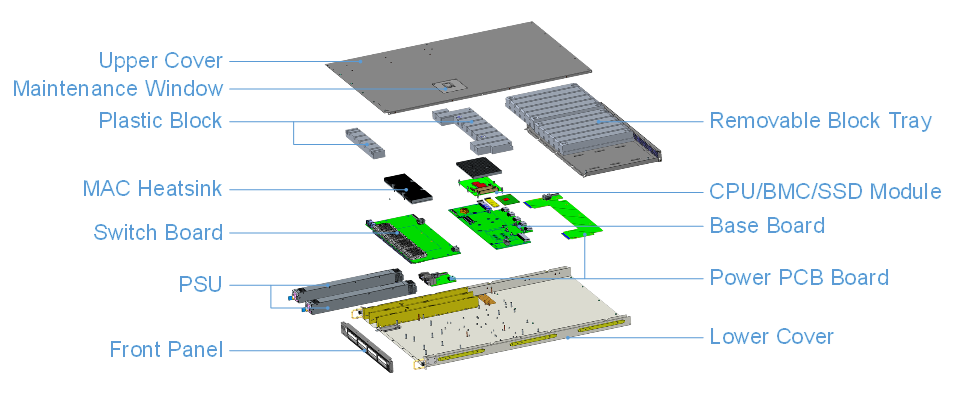

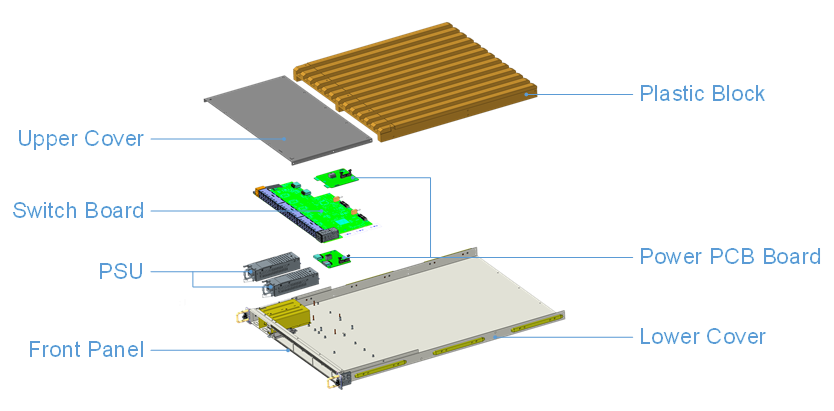

图6 交换机结构进化

对此,锐捷采用了冷板式液冷散热器,对MAC芯片和周围的光模块进行一体化覆盖,通过冷却液在板内流道的流动带走热量。同时,为了尽可能降低液体管路的复杂性和泄露风险,设备的其他发热器件还是通过风扇进行散热。冷板散热方案可谓一举两得,既能满足NPO/CPO大功率高密度热源的散热需求,又可让设备高度可以减少到极薄的1RU。

锐捷网络液冷交换机研发成果

锐捷网络在液冷领域的研发成果也可圈可点。

2019年, 锐捷网络就配合国内某互联网客户交付了浸没式液冷的32*100Gbps数据中心交换机以及对应的千兆网管交换机。

2022年,锐捷网络开始布局100/200/400G浸没式液冷交换机及冷板式液冷交换机。

锐捷网络目前推出了2款商用浸没式液冷交换机,分别是32口100G数据中心接入交换机和48口1G的管理网交换机。两款交换机都是21 英寸宽,兼容3M FC-40冷却液;电源支持1+1冗余;可插拔 ABS+PC 模块大幅节省冷却液成本,模块上的凹槽方便液体流动进行散热,并巧妙地平衡了浮力和重力。

图7 32*100G 浸没式液冷数据中心接入交换机

图8 48*1G+4*10G 浸没式液冷管理网交换机

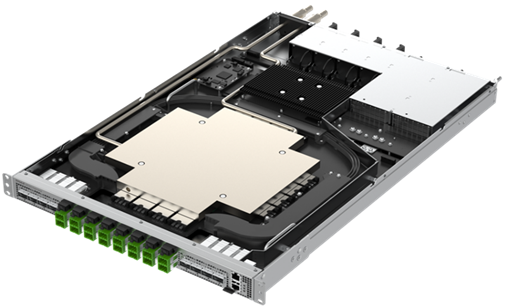

在2021年11月全球OCP峰会,锐捷网络正式发布64*400G冷板式液冷NPO交换机,满足数据中心和运营商网络的高可靠性要求。

图9 64*400G冷板式液冷NPO数据中心交换机

在OIF的主导下,锐捷网络联合业界多家厂商于2022 OFC峰会,发布64*800G冷板式液冷NPO交换机结构样机。前面板支持64个800G光纤连接器,每个连接器还可以分成2个400G端口,实现向前兼容。外置激光源模块增加到了16个,由于采用了Blind-mate设计,避免了高功率激光对人眼的伤害,更大程度保障了运维人员的安全。交换机芯片和NPO模块支持冷板冷却方式,高效散热,解决热流密度高度集中的难题。对比同性能、传统可插拔光模块+风冷方案的交换机,功耗大幅降低。

图10 64*800G冷板式液冷NPO数据中心交换机

锐捷网络率先让液冷技术应用于数据中心交换机,既解决自身散热难题,又能和液冷服务器统一部署,便于数据中心基础设施的统一建设和运维。未来,锐捷网络会在散热方向上继续走这条可持续发展之路,支持交换新技术发挥更大的性能,研发出更多数据中心好产品,共筑绿色数字经济。

补充

为什么说硅光子技术前景乐观,什么是硅光技术,有哪些优势,应用领域是什么,以及现在面临哪些问题?

硅光子技术是一种光通信技术,使用激光束代替电子半导体信号传输数据,是基于硅和硅基衬底材料,利用现有CMOS工艺进行光器件开发和集成的新一代技术。最大的优势在于拥有相当高的传输速率,可使处理器内核之间的数据传输速度快100倍甚至更高,功率效率也非常高,因此被认为是新一代半导体技术。

详情:https://www.zhihu.com/question/468749534?utm_id=0

作者:锐捷网络 Mephisto、浅潜小龙

来源:未知

①凡本网注明"信息来源:热传商务网"的所有文章,版权均属于本网,未经本网授权不得转载、摘编或利用其它方式使用。

②来源第三方的信息,本网发布的目的在于分享交流,不做商业用途,亦不保证或承诺内容真实性等。如有侵权,请及时联系本网删除。联系方式:7391142@qq.com

热传商务网-热传散热产品智能制造信息平台

热传商务网-热传散热产品智能制造信息平台