国之大者,在于谋长远,成长治。美丽中国建设,离不开绿色低碳和高质量发展。

数据中心作为当今数字经济蓬勃发展重要底座,在为千行百业提供新动能的同时,其能耗也在规模不断扩大的过程中快速增加。有数据显示,数据中心能耗已占社会用电量的约4%,这让数据中心能耗有效性备受关注。为此,国家发改委等多部门密集出台政策,提出到2025年新建大型、超大型数据中心 PUE(Power Usage Efficiency,电能利用效率)低于1.3,国家枢纽节点低于1.25等严格要求,强调加强数据、算力和能源之间的协同联动,加速节能低碳的技术创新和模式创新,促进了冷板液冷等先进散热技术成为绿色数据中心建设的重要抓手。

数据中心加速绿色转型,液冷技术势在必行

据数据中心绿色能源技术联盟统计数据显示,目前大多数传统数据中心PUE 值在1.5 以上。其中一部分原因是在数字化转型驱动下,计算密集型应用场景激增,加上云业务的广为采用,导致承载这些应用负载的服务器等IT设备功耗大幅增加,使得数据中心设计功率密度呈现逐年增大的趋势;另外,为了满足高算力负载需求,数据中心需要叠加多核处理器来提高计算密度,从而显著增加处理器等硬件的功耗。

但 IT 设备本身能源消耗过高却并非是PUE值偏高的主要问题,服务器数量与密度的增加,以及机架密度升高所带来巨大散热压力才是症结所在。据统计,来自数据中心冷却系统等非 IT 负载所消耗的能源占比超过总耗能的三分之一,甚至占到40%,已经成为了数据中心可持续发展道路上不可避免的一大挑战。

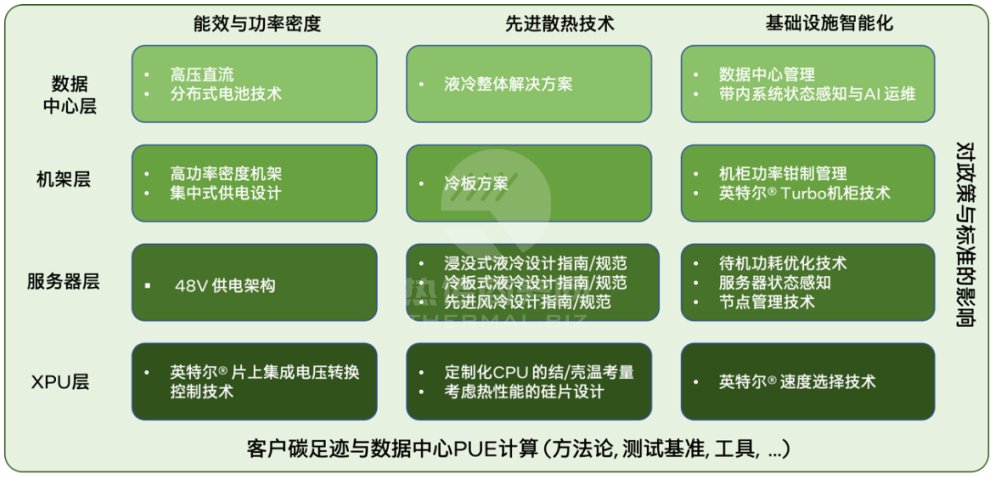

为了帮助数据中心应对上述挑战,英特尔推出“四横三纵”矩阵型绿色数据中心技术框架,也被形象地称为“绿菜单”,聚焦能效与功率密度、先进散热技术和基础设施智能化三个垂直领域,从 XPU 等器件级到服务器系统、机架和数据中心四个层面,提供了一系列整体解决方案和参考设计,并将散热技术置于关键地位。

图一英特尔绿色数据中心技术框架

目前,传统数据中心的散热方式主要通过风冷手段进行,即以空气作为冷媒带走热量。虽然通过技术优化,比如提升风冷设备的体积、面积、热管技术,以及实施从机架到节点的各种调优,也可将数据中心PUE降到1.2左右。但是据测算,单机架功率密度到 2025 年将是 2021 年的 5 倍,使得过去能满足 12kW 以内机柜制冷需求的风冷措施,已无法应对随服务器单位功耗增大,原先尺寸的机柜可容纳服务器功率往往超过 15kW 的现实需求,更遑论让数据中心维持能耗成本与收益的平衡,可见风冷技术已趋于能力上限。

数据中心产业需要探索新的技术来帮助充分释放计算的潜能,同时促进绿色可持续,而液冷技术恰逢其时,脱颖而出。所谓液冷,通俗来讲就是通过液体代替空气,把CPU、内存等IT发热器件产生的热量带走。液冷正在取代目前数据中心普遍采用的风冷技术,逐步成为推进数据中心绿色转型的关键动力。

那么,液冷技术为何受到青睐呢?

首先,液冷系统能够在更靠近热量来源的位置与液冷介质进行热交换,避免空气湍流和空气混合;其次,液体比空气具有更高的热容量和更低的热阻,对于同样体积的传热介质,冷却剂能以空气的6倍速度传递热量,蓄热量是空气的 1000 倍;第三,与风冷相比,冷却液的传热次数更少,容量衰减更小,效率更高,这还意味散热过程中驱动冷却介质所需的能耗更低,循环系统耗能少。

基于液冷的优秀散热能力,英特尔积极携手产业伙伴推动其技术创新和应用,并从处理器定制和服务器系统开发与优化着手,突破芯片功耗墙和冷却两大影响算力提升的关键问题,使得液冷服务器实现大规模部署,有专家称是第三代英特尔® 至强® 可扩展处理器使液冷技术走向了商业化落地。

图二 第三代英特尔® 至强® 可扩展处理器

释放技术之功,推进冷板液冷方案落地

目前,液冷系统的技术路线可以分为浸没式液冷、冷板液冷和喷雾液冷。

浸没式液冷技术,通俗理解就是把服务器完全浸没在制冷液当中,可以100%把热量捕捉并传导出去,但是可能会颠覆现有数据中心设计的一些原则,成本也比较高,大规模应用尚存问题;喷雾液冷模式在降温过程中,则存在冷却介质遇到高温电子部件而出现飘溢问题,会影响机房及设备环境。

而冷板液冷技术,通过传导热量的冷媒在冷板内部通道流动,使IT部件冷却而不接触液体,让现有服务器芯片组件及附属部件改动量较小、可操作性更强,由此成为了目前成熟度更高、应用更广泛的数据中心液冷散热方案,具备显著优势:

•冷却能力高,所需的实施空间更小,可提高系统功率密度;

•可将数据中心 50%~80% 的散热转移到外部冷却塔,显著降低 PUE和碳排放;

•通过冷却高性能处理器和提升服务器机架功率密度,实现性能最大化,提升数据中心算力输出能力;

•能够提高云主机服务等级协议(SLA),以及处理器、服务器和数据中心可靠性。

为了发挥冷板液冷的独特优势,加速驱动数据中心实现绿色高质量发展,英特尔与生态伙伴协同创新,为冷板液冷方案设计与研究提供了参考路径。

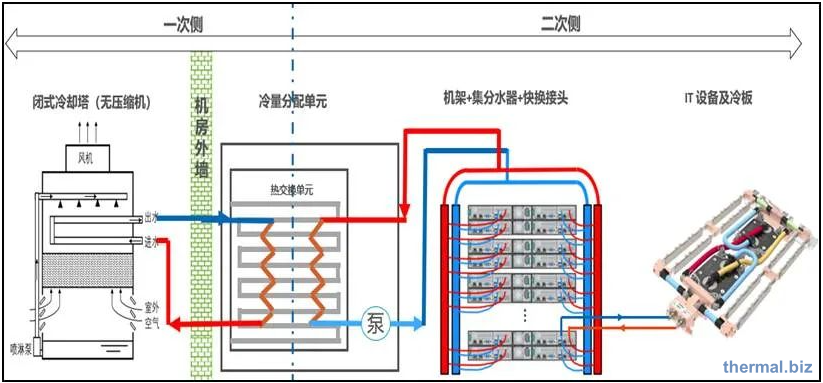

冷板液冷参考设计覆盖液冷整个链路,涉及一次侧和二次侧系统。从链路图可以看出,一次侧是指从机房外至机房内冷量分配单元的热量交换系统,二次侧是指从冷量分配单元到机架的二次侧液体回路,负责机房内部的热量交换。

图三 冷板式液冷整体链路图

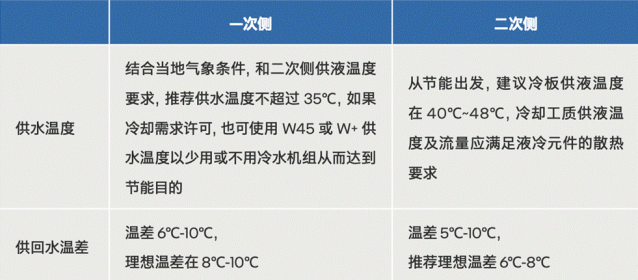

表 一 一次侧和二次侧供液温度的参考值

二次侧液体回路从冷量分配单元到机架,通过供回冷却工质歧管和IT设备连接,然后再通过歧管返回冷量分配单元的设计。来自二次侧冷却回路的热量通过冷量分配单元的板式热交换器传递到一次侧冷却回路,最终排放到大气中或被热回收再利用。

随着IT设备以及机柜功率密度的增加,二次侧需要效率更高的冷板等液冷技术来实施冷却。而何时转换冷却方式,尤其对于CPU和GPU等高功耗元器件,究竟何时或在何种功率水平下需要液体冷却,尽管尚无通用指南,但应注意的是,除了成本分析外,还须全面了解冷板液冷方案的设计考量,方能以制冷模式变革,帮助数据中心突破降碳增效瓶颈。

凝聚生态之力,加速冷板液冷应用工程实践

为了面向更广泛的产业伙伴展现冷板液冷技术研究进展,助力整个行业突破关键部件设计、制造和应用门槛,进而以更低成本促进数据中心采用新技术走向绿色可持续,英特尔在积极探索液冷技术与方案创新应用的基础上,还与产业上下游厂商紧密合作,更全面、更系统化地总结了冷板系统的设计实践经验,发布了创新成果《绿色数据中心创新实践——冷板液冷系统设计参考》,为参与冷板散热系统设计、验证、管路的连接组装、系统检测以及维护等全产业链实践提供路径和指导,促进集成式创新与工程加速落地。

与此同时,英特尔还携手生态伙伴,不断加速冷板方案落地应用,为数据中心绿色转型打造新典范。比如浪潮信息,与英特尔在冷板液冷产业紧密合作,已实现服务器全产品线支持冷板式液冷,并提供液冷数据中心整体解决方案,还建成了亚洲最大的液冷数据中心研发生产基地,实现PUE低于1.1。

又如,京东云与英特尔合作,采用定制型第三代英特尔® 至强® 可扩展处理器,推出冷板液冷解决方案,部署后,将数据中心 PUE 从 1.3 降到了 1.1,每个 14千瓦机柜可年节电 31,031 度,碳减排 24.4 吨,且宕机率降低40%。

实现绿色发展是一场深刻革命,而科技是推动这场革命的第一生产力,创新则是第一动力。整个产业协力推进,无疑更能以生态合力让绿色转型获得加速。因此,在推进冷板液冷等创新技术应用,驱动可持续数据中心建设的进程中,英特尔也与多家伙伴合作,成立了绿色数据中心技术创新论坛,携手构建定制化绿色节能解决方案,以便全方位推动数据中心提供更高算力并持续锁“碳”减排,为新型基础设施建设树立新标杆,同时进一步策源技术变革,为人与自然和谐共生的现代化贡献更大力量。

作者:中国电子报

来源:百度百家号

①凡本网注明"信息来源:热传商务网"的所有文章,版权均属于本网,未经本网授权不得转载、摘编或利用其它方式使用。

②来源第三方的信息,本网发布的目的在于分享交流,不做商业用途,亦不保证或承诺内容真实性等。如有侵权,请及时联系本网删除。联系方式:7391142@qq.com

热传商务网-热传散热产品智能制造信息平台

热传商务网-热传散热产品智能制造信息平台